.NET 10 性能优化

.NET 10的性能故事并非迪士尼式的魔法奇想,而是通过在操作中精雕细琢——此处削减纳秒级延迟,彼处压缩数十字节数据——最终优化了万亿次级别的运行操作。

目录

- 基准测试环境

- 即时编译

- 去抽象化

- 边界检查

- 克隆

- 内联

- 常量折叠

- 代码布局

- GC写屏障

- 指令集

- 杂项

- 原生AOT

- 虚拟机

- 线程处理

- 反射

- 基本类型与数值

- 集合

- 枚举

- LINQ

- 冻结集合

- 位数组

- 其他集合

- 输入输出

- 网络通信

- 搜索技术

- 正则表达式

- 搜索值

- 内存扩展

- JSON

- 诊断工具

- 密码学

- 花生酱

- 后续计划

我的孩子们 超爱 《冰雪奇缘》。他们能唱出每个字、重现每个场景,还能详细说明艾莎冰裙的闪耀效果。我看的次数多到数不清,以至于如果你看过我的现场编程演示,很可能见过我的潜意识里冒出个一两个阿伦黛尔的梗。反复观影后,我开始留意更多细节——比如影片开场采冰工人的歌谣,如何巧妙预示了故事的核心冲突、角色成长轨迹,甚至揭示了高潮转折的关键。说来惭愧,直到第十次观影时我才领悟到这种关联,那时我才意识到自己根本不清楚采冰是否真实存在,还是迪士尼编故事的巧妙噱头。后来查证才发现,这竟是真实存在的行业。

十九世纪制冷技术尚未普及时,冰块堪称珍贵商品。美国北部的冬季将池塘湖泊化作季节性金矿。最成功的采冰作业精准高效:工人先清除冰面积雪以促进冰层增厚硬化,再用马犁在冰面划出规整矩形,将湖面变成冰封的棋盘。切割完成后,工人们用长锯切割出每块重达数百磅的均匀冰块。这些冰块沿着开阔水域的通道漂向岸边,随后工人们用长杆将冰块撬上斜坡,拖入储藏室。基本上,电影里展示的就是这个过程。

储藏本身也是一门艺术。巨大的木制冰库有时可储存数万吨冰块,内部通常用稻草等材料进行隔热处理。若隔热得当,冰块可保持数月坚实,甚至抵御盛夏酷暑;若处理不当,开门便见冰渣。对于需长途运输冰块(通常靠船运)的商人而言,每度温差、每处隔热裂缝、每多一天运输时间,都意味着更多融化与损失。

此时,波士顿“冰王”弗雷德里克·图德登场。他痴迷于系统效率优化。当竞争对手视损失为必然时,他却发现可解之题。经反复试验,他最终采用廉价的锯末——这种锯木厂副产品比稻草更具隔热性。将锯末紧密填充于冰块周围,大幅降低了融化损失。为提升采冰效率,他的团队采用纳撒尼尔·贾维斯·怀斯的网格切割系统,生产出可紧密堆叠的规则冰块,最大限度减少了货舱内易导致冰块暴露的空气间隙。为缩短岸上装运至船上的关键时间,都铎在港口附近扩建仓储设施,使船舶装卸效率倍增。从工具革新到冰库设计再到物流优化,每项改进都形成良性循环,将高风险的本地采冰转变为可靠的全球贸易。得益于都铎的改进,哈瓦那、里约热内卢乃至加尔各答(1830年代航程需四个月)都能收到坚实冰块。其效能提升使产品得以完成此前难以想象的长途运输。

让都铎的冰块能跨越半个地球的并非某个重大创新,而是无数微小改进层层叠加产生的倍增效应。软件开发领域同样遵循此则:性能的飞跃性提升鲜少源于单次颠覆性变革,而是由成百上千次精准优化层层叠加而成的变革性突破。.NET 10的性能故事并非迪士尼式的魔法奇想,而是通过在操作中精雕细琢——此处削减纳秒级延迟,彼处压缩数十字节数据——最终优化了万亿次级别的运行操作。

在本篇后续内容中,我们将延续此前在.NET 9、.NET 8、 .NET 7、.NET 6、.NET 5、.NET Core 3.0、.NET Core 2.1 以及 .NET Core 2.0,我们将深入探讨自 .NET 9 以来数百项细微却意义重大且具有累积效应的性能优化,这些改进共同构成了 .NET 10 的核心故事(若您选择继续使用 LTS 版本,因此是从 .NET 8 升级而非从 .NET 9 升级, 您还将看到基于所有.NET 9改进的聚合成果带来的更多提升)。那么,别再犹豫了,去倒一杯您最爱的热饮(或者,考虑到我的开场白,或许来点更冰凉的饮品),放松身心,尽情享受吧!

或者,嗯,或许该把性能推向“未知领域”?

让.NET 10的性能“展现真我”?

“你想建造一个雪人快速服务吗?”

我这就告辞。

基准测试环境§

与往期内容相同,本次巡礼包含大量微基准测试,旨在展示各类性能提升。多数测试采用BenchmarkDotNet 0.15.2实现,每个测试均采用简易配置。

若需跟进操作,请确保已安装.NET 9和.NET 10,因多数基准测试需在两个平台上运行相同测试进行对比。接着在新建的benchmarks目录中创建C#项目:

dotnet new console -o benchmarks

cd benchmarks这将在benchmarks目录生成两个文件:benchmarks.csproj(包含应用程序编译信息的项目文件)和Program.cs(应用程序代码文件)。最后将benchmarks.csproj中的内容替换为以下代码:

<Project Sdk="Microsoft.NET.Sdk">

<PropertyGroup>

<OutputType>Exe</OutputType>

<TargetFrameworks>net10.0;net9.0</TargetFrameworks>

<LangVersion>Preview</LangVersion>

<ImplicitUsings>enable</ImplicitUsings>

<Nullable>enable</Nullable>

<ServerGarbageCollection>true</ServerGarbageCollection>

</PropertyGroup>

<ItemGroup>

<PackageReference Include="BenchmarkDotNet" Version="0.15.2" />

</ItemGroup>

</Project>至此准备就绪。除非另有说明,每个基准测试均设计为独立运行:只需将完整内容复制粘贴至 Program.cs 文件覆盖原有内容,即可运行测试。每个测试开头均包含 dotnet 命令的注释说明,通常如下所示:

dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0该命令将在.NET 9和.NET 10环境下以发布模式运行基准测试并显示对比结果。另一种常见变体用于仅在.NET 10环境运行测试(通常用于比较两种方案而非同一方案在不同版本间的差异),格式如下:

dotnet run -c Release -f net10.0 --filter "*"本文展示了大量基准测试及其运行结果。除非特别说明(例如演示操作系统特有的性能提升),所有结果均基于x64处理器上的Linux系统(Ubuntu 24.04.1)运行所得。

BenchmarkDotNet v0.15.2, Linux Ubuntu 24.04.1 LTS (Noble Numbat)

11th Gen Intel Core i9-11950H 2.60GHz, 1 CPU, 16 logical and 8 physical cores

.NET SDK 10.0.100-rc.1.25451.107

[Host] : .NET 9.0.9 (9.0.925.41916), X64 RyuJIT AVX-512F+CD+BW+DQ+VL+VBMI惯例声明:这些是微基准测试,计时操作短到眨眼间就会错过(但当这类操作运行数百万次时,节省的时间就相当可观了)。您获得的确切数值将取决于您的硬件、操作系统、机器当前处理的其他任务、早餐后喝了多少咖啡,甚至可能取决于水星是否逆行。换言之,别指望你的结果与我完全一致,但我选取的测试在现实场景中仍应具备合理可复现性。

现在,让我们从栈底开始——代码生成环节。

JIT§

在.NET所有领域中,即时编译器(JIT)堪称最具影响力的组件之一。无论是小型控制台工具还是大型企业级服务,所有.NET应用最终都依赖JIT将中间语言(IL)代码转化为优化后的机器码。JIT生成的代码质量提升具有连锁效应——无需开发者修改代码甚至重新编译C#,就能提升整个生态系统的性能。而.NET 10版本中,这类改进可谓层出不穷。

消除抽象§

与许多语言类似,.NET 历史上存在“抽象开销”——使用接口、迭代器和委托等高级语言特性时可能产生的额外分配和间接操作。每年,即时编译器(JIT)都在不断优化抽象层,使开发者能够编写简洁代码并获得卓越性能。.NET 10 延续了这一传统。其结果是,符合惯例的 C# 代码(使用接口、foreach 循环、lambda 表达式等)的运行速度已逼近精心编写并手动调优的代码的原始速度。

对象栈分配

.NET 10 在消除抽象方面的最令人振奋的进展之一,是扩展了逃逸分析的应用范围,从而实现了对象的栈分配。逃逸分析是编译器技术,用于判断方法中分配的对象是否逃逸该方法——即确定对象在方法返回后是否仍可被访问(例如存储在字段中或返回给调用方),或以运行时无法追踪的方式在方法内被使用(如传递给未知调用方)。若编译器能证明对象不存在逃逸,则该对象的生命周期仅限于方法内部,可直接在栈上分配而非堆上分配。栈分配成本更低(仅需指针递增分配,方法退出时自动释放),且能减轻垃圾回收压力——毕竟对象无需被垃圾回收器追踪。.NET 9已引入有限的逃逸分析与栈分配支持;.NET 10在此基础上实现了重大突破。

dotnet/runtime#115172 指导 JIT 执行与委托相关的逃逸分析,特别是指出委托的 Invoke 方法(由运行时实现)不会隐藏 this 引用。当逃逸分析能证明委托的对象引用属于未逃逸资源时,该委托即可被有效消除。请看以下基准测试:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[MemoryDiagnoser(displayGenColumns: false)]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD", "y")]

public partial class Tests

{

[Benchmark]

[Arguments(42)]

public int Sum(int y)

{

Func<int, int> addY = x => x + y;

return DoubleResult(addY, y);

}

private int DoubleResult(Func<int, int> func, int arg)

{

int result = func(arg);

return result + result;

}

}若直接运行此基准测试并比较 .NET 9 与 .NET 10 的结果,可立即发现有趣现象。

| Method | Runtime | Mean | Ratio | Code Size | Allocated | Alloc Ratio |

|---|---|---|---|---|---|---|

| Sum | .NET 9.0 | 19.530 ns | 1.00 | 118 B | 88 B | 1.00 |

| Sum | .NET 10.0 | 6.685 ns | 0.34 | 32 B | 24 B | 0.27 |

Sum的C#代码背后隐藏着编译器的复杂代码生成机制。它需要创建一个Func<int, int>,该函数会“闭包”作用于局部变量y。这意味着编译器需要将y“提升”为非实际局部变量,转而作为对象的字段存在;委托即可指向该对象的方法,从而访问y。以下是C#编译器生成的IL反编译为C#后的近似形态:

public int Sum(int y)

{

<>c__DisplayClass0_0 c = new();

c.y = y;

Func<int, int> func = new(c.<Sum>b__0);

return DoubleResult(func, c.y);

}

private sealed class <>c__DisplayClass0_0

{

public int y;

internal int <Sum>b__0(int x) => x + y;

}由此可见,闭包导致了两次内存分配:一次是为“显示类”(C#编译器对这类闭包类型的称谓)分配内存,另一次是为指向该显示类实例上<Sum>b__0方法的委托分配内存。这正是.NET 9结果中88字节分配的来源:显示类占24字节,委托占64字节。但在.NET 10版本中,我们仅看到24字节分配——这是因为JIT成功省略了委托分配。以下是生成的程序集代码:

; .NET 9

; Tests.Sum(Int32)

push rbp

push r15

push rbx

lea rbp,[rsp+10]

mov ebx,esi

mov rdi,offset MT_Tests+<>c__DisplayClass0_0

call CORINFO_HELP_NEWSFAST

mov r15,rax

mov [r15+8],ebx

mov rdi,offset MT_System.Func<System.Int32, System.Int32>

call CORINFO_HELP_NEWSFAST

mov rbx,rax

lea rdi,[rbx+8]

mov rsi,r15

call CORINFO_HELP_ASSIGN_REF

mov rax,offset Tests+<>c__DisplayClass0_0.<Sum>b__0(Int32)

mov [rbx+18],rax

mov esi,[r15+8]

cmp [rbx+18],rax

jne short M00_L01

mov rax,[rbx+8]

add esi,[rax+8]

mov eax,esi

M00_L00:

add eax,eax

pop rbx

pop r15

pop rbp

ret

M00_L01:

mov rdi,[rbx+8]

call qword ptr [rbx+18]

jmp short M00_L00

; Total bytes of code 112

; .NET 10

; Tests.Sum(Int32)

push rbx

mov ebx,esi

mov rdi,offset MT_Tests+<>c__DisplayClass0_0

call CORINFO_HELP_NEWSFAST

mov [rax+8],ebx

mov eax,[rax+8]

mov ecx,eax

add eax,ecx

add eax,eax

pop rbx

ret

; Total bytes of code 32在.NET 9和.NET 10中,JIT都成功内联了DoubleResult,使得委托未逃逸,但.NET 10进一步实现了栈分配。太棒了!显然仍有优化空间——JIT尚未消除闭包对象的分配,但这应能通过进一步努力解决,希望不久的将来就能实现。

dotnet/runtime#104906 由 @hez2010 提出,及 dotnet/runtime#112250 将此类分析与栈分配扩展至数组场景。你是否曾多次编写过类似代码?

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

using System.Runtime.CompilerServices;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[MemoryDiagnoser(displayGenColumns: false)]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

[Benchmark]

public void Test()

{

Process(new string[] { "a", "b", "c" });

static void Process(string[] inputs)

{

foreach (string input in inputs)

{

Use(input);

}

[MethodImpl(MethodImplOptions.NoInlining)]

static void Use(string input) { }

}

}

}某些需要调用的方法接受输入数组,并对每个输入执行操作。我必须显式分配数组传递输入,或因使用params参数或集合表达式而隐式分配。理想情况下,未来应提供Process方法的重载版本,使其接受ReadOnlySpan<string>而非string[],从而在构造时避免分配操作。但在所有必须创建数组的场景中,.NET 10 提供了解决方案。

| Method | Runtime | Mean | Ratio | Allocated | Alloc Ratio |

|---|---|---|---|---|---|

| Test | .NET 9.0 | 11.580 ns | 1.00 | 48 B | 1.00 |

| Test | .NET 10.0 | 3.960 ns | 0.34 | – | 0.00 |

JIT 编译器能够将 Process 内联,识别出数组始终未离开调用帧,并采用栈分配方式实现。

当然,既然我们现在能够为数组进行栈分配,我们也希望能够处理数组的一种常见用法:通过span进行访问。dotnet/runtime#113977 和 dotnet/runtime#116124 通过逃逸分析来处理结构体中的字段,其中包含 Span<T>,因为它“仅仅”是一个存储 ref T 字段和 int 长度字段的结构体。

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

using System.Runtime.CompilerServices;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[MemoryDiagnoser(displayGenColumns: false)]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private byte[] _buffer = new byte[3];

[Benchmark]

public void Test() => Copy3Bytes(0x12345678, _buffer);

[MethodImpl(MethodImplOptions.NoInlining)]

private static void Copy3Bytes(int value, Span<byte> dest) =>

BitConverter.GetBytes(value).AsSpan(0, 3).CopyTo(dest);

}此处使用 BitConverter.GetBytes 方法,该方法会分配一个包含输入字节的 byte[] 数组(本例中为存储 int 的四字节数组),随后截取其中三个字节并复制到目标 Span 中。

| Method | Runtime | Mean | Ratio | Allocated | Alloc Ratio |

|---|---|---|---|---|---|

| Test | .NET 9.0 | 9.7717 ns | 1.04 | 32 B | 1.00 |

| Test | .NET 10.0 | 0.8718 ns | 0.09 | – | 0.00 |

在 .NET 9 中,GetBytes 中的 byte[] 会按预期分配 32 字节(64 位系统中每个对象至少占用 24 字节,其中包含数组长度的 4 字节,数据部分的 4 字节位于第 24-27 个存储单元, 大小会被补足至下一个字边界,达到32字节)。而在.NET 10中,由于GetBytes和AsSpan被内联,JIT能识别该数组未溢出栈,因此可使用栈分配版本为span初始化,如同从其他栈分配(如stackalloc)创建时一样。(此案例还受益于dotnet/runtime#113093的改进,该改进使JIT理解到某些span操作——如CopyTo内部使用的Memmove——属于非逃逸操作。)

虚拟化消除

接口与虚方法是.NET及其抽象机制的核心要素。能够展开这些抽象并实现“虚拟化消除”,是JIT的重要任务,而.NET 10在此领域取得了显著突破。

尽管数组是C#和.NET的核心特性之一,且JIT投入大量精力优化了数组的诸多方面,但数组的接口实现始终是其痛点所在。运行时为T[]生成大量接口实现,由于其实现方式与.NET中其他所有接口实现截然不同,JIT无法像处理其他接口那样应用去虚拟化技术。对于深入研究微基准测试的人而言,这会导致一些奇怪的现象。以下是使用foreach循环(遍历枚举器)与for循环(逐个索引元素)遍历ReadOnlyCollection<T>的性能对比:

// dotnet run -c Release -f net9.0 --filter "*"

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

using System.Collections.ObjectModel;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private ReadOnlyCollection<int> _list = new(Enumerable.Range(1, 1000).ToArray());

[Benchmark]

public int SumEnumerable()

{

int sum = 0;

foreach (var item in _list)

{

sum += item;

}

return sum;

}

[Benchmark]

public int SumForLoop()

{

ReadOnlyCollection<int> list = _list;

int sum = 0;

int count = list.Count;

for (int i = 0; i < count; i++)

{

sum += _list[i];

}

return sum;

}

}若问“哪种方式更快”,显而易见的答案是“SumForLoop”。毕竟SumEnumerable需要分配枚举器,且每次迭代需执行两倍接口调用(MoveNext+Current vs this[int])。然而事实证明,这个显而易见的答案是错误的。以下是在我的机器上针对 .NET 9 的计时结果:

| Method | Mean |

|---|---|

| SumEnumerable | 949.5 ns |

| SumForLoop | 1,932.7 ns |

怎么回事??然而,如果将 ToArray 改为 ToList,结果就更符合预期了。

| Method | Mean |

|---|---|

| SumEnumerable | 1,542.0 ns |

| SumForLoop | 894.1 ns |

究竟发生了什么?问题极其微妙。首先需明确:ReadOnlyCollection<T> 仅封装任意 IList<T>,其 GetEnumerator() 方法会调用 _list.GetEnumerator() (此处暂不讨论列表为空的特殊情况),而ReadOnlyCollection<T>的索引器本质上是调用IList<T>的索引器。到目前为止,这似乎符合预期。但真正有趣的是JIT编译器能否实现方法反虚化。在 .NET 9 中,JIT 难以对 T[] 上的接口实现调用进行去虚拟化,因此既不会对 _list.GetEnumerator() 调用去虚拟化,也不会对 _list[index] 调用去虚拟化。然而,枚举器本身只是实现IEnumerator<T>的普通类型,JIT对MoveNext和Current成员的反虚化毫无障碍。这意味着通过索引器访问的开销远高于枚举器:当元素数量为 N 时,索引器需执行 N 次接口调用,而枚举器仅需一次 GetEnumerator 接口调用即可完成后续操作。

值得庆幸的是,此问题已在 .NET 10 中得到修复。dotnet/runtime#108153、dotnet/runtime#109209、dotnet/runtime# 109237 和 dotnet/runtime#116771 均使 JIT 能够对数组的接口方法实现进行去虚拟化。现在当我们运行相同的基准测试(恢复使用ToArray)时,结果更符合预期:两个基准测试在.NET 9到.NET 10的升级中均有提升,其中SumForLoop在.NET 10环境下表现最快。

| Method | Runtime | Mean | Ratio |

|---|---|---|---|

| SumEnumerable | .NET 9.0 | 968.5 ns | 1.00 |

| SumEnumerable | .NET 10.0 | 775.5 ns | 0.80 |

| SumForLoop | .NET 9.0 | 1,960.5 ns | 1.00 |

| SumForLoop | .NET 10.0 | 624.6 ns | 0.32 |

其中一个真正有趣的现象是,许多库都基于这样一个前提进行实现:使用IList<T>的索引器进行迭代比使用其IEnumerable<T>更快,这包括System.Linq库。多年来,LINQ在可能的情况下始终采用专属代码路径处理IList<T>,虽然多数场景下这是有益的优化,但在 某些 情况下(例如具体类型为ReadOnlyCollection<T>时),反而会导致性能退化。

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

using System.Collections.ObjectModel;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private ReadOnlyCollection<int> _list = new(Enumerable.Range(1, 1000).ToArray());

[Benchmark]

public int SkipTakeSum() => _list.Skip(100).Take(800).Sum();

}| Method | Runtime | Mean | Ratio |

|---|---|---|---|

| SkipTakeSum | .NET 9.0 | 3.525 us | 1.00 |

| SkipTakeSum | .NET 10.0 | 1.773 us | 0.50 |

修复数组接口实现的反虚拟化问题,同样会对LINQ产生传递性影响。

.NET 10中还改进了受保护的反虚拟化(GDV),例如dotnet/runtime#116453 和 dotnet/runtime#109256。借助动态PGO,JIT编译器能够对方法编译过程进行仪器化,并利用生成的剖析数据优化方法版本。其剖析功能之一是识别虚拟调用中使用的类型。若某类型占主导地位,代码生成器可将其作为特殊情况处理,生成针对该类型的定制化实现。这便能在专属路径中实现去虚拟化,该路径由相关类型检查“守护”,故称“GDV”。但某些情况下(例如在共享泛型上下文中调用虚函数时),GDV不会生效。如今这一问题已得到解决。

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

using System.Runtime.CompilerServices;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

[Benchmark]

public bool Test() => GenericEquals("abc", "abc");

[MethodImpl(MethodImplOptions.NoInlining)]

private static bool GenericEquals<T>(T a, T b) => EqualityComparer<T>.Default.Equals(a, b);

}| Method | Runtime | Mean | Ratio |

|---|---|---|---|

| Test | .NET 9.0 | 2.816 ns | 1.00 |

| Test | .NET 10.0 | 1.511 ns | 0.54 |

dotnet/runtime#110827 提案由 @hez2010 提出,通过在脱虚拟化后期阶段进行额外扫描寻找优化机会,进一步提升方法内联率。JIT 优化被拆分为多个阶段;每个阶段都能带来改进,而这些改进又会揭示新的优化机会。若这些机会只能由已运行的阶段利用,则可能被遗漏。但对于执行成本较低的阶段(如搜索额外内联机会的遍历),当其他优化已足够充分时,这些阶段可重复执行以提升效率。

边界检查§

C#作为内存安全的语言,体现了现代编程语言的重要特性。其核心机制在于禁止越界访问数组、字符串或span的起始/末尾位置。运行时确保任何此类无效尝试都会抛出异常,而非允许执行非法内存访问。通过小型基准测试可观察其工作原理:

// dotnet run -c Release -f net10.0 --filter "*"

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private int[] _array = new int[3];

[Benchmark]

public int Read() => _array[2];

}这是合法访问:_array包含三个元素,Read方法正在读取其最后一个元素。然而JIT无法100%确定此访问是否在边界内(可能有操作将_array字段改为更短的数组),因此需要生成检查代码以确保不会越界访问数组末尾。以下是Read方法生成的汇编代码:

; .NET 10

; Tests.Read()

push rax

mov rax,[rdi+8]

cmp dword ptr [rax+8],2

jbe short M00_L00

mov eax,[rax+18]

add rsp,8

ret

M00_L00:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 25this引用通过rdi寄存器传递至Read实例方法,而_array字段位于偏移量8处,因此mov rax,[rdi+8]指令将数组地址加载至rax寄存器。随后cmp指令从该地址加载偏移量8处的值——恰好数组对象的数组长度存储在此处。因此该cmp指令即为边界检查:通过将2与数组长度比较来确保访问合法。若数组长度不足以支持此访问,后续的jbe指令将跳转至M00_L00标签,调用CORINFO_HELP_RNGCHKFAIL辅助函数抛出IndexOutOfRangeException异常。每当在方法末尾看到 call CORINFO_HELP_RNGCHKFAIL/int 3 这对指令时,说明该方法中至少存在一次由 JIT 编译器生成的边界检查。

当然,我们不仅追求安全性,更追求卓越性能。若每次数组(或字符串、span)读取都需额外检查,将严重影响性能。因此,当访问操作在构造上可被证明安全时,JIT会努力避免生成冗余的边界检查。例如,我稍作调整基准测试,将数组从实例字段移至static readonly字段:

// dotnet run -c Release -f net10.0 --filter "*"

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private static readonly int[] s_array = new int[3];

[Benchmark]

public int Read() => s_array[2];

}此时生成的汇编代码如下:

; .NET 10

; Tests.Read()

mov rax,705D5419FA20

mov eax,[rax+18]

ret

; Total bytes of code 14static readonly 字段不可变,数组无法调整大小,且 JIT 编译器能确保在生成 Read 方法代码前该字段已初始化。因此在生成 Read 代码时,它能确知数组长度为三,且当前访问的是索引为二的元素。这意味着指定的数组索引必然在边界范围内,无需进行边界检查。我们仅需两条mov指令:第一条mov加载数组地址(得益于前几版改进,数组分配在无需紧凑化的堆上,故地址固定),第二条mov读取索引位置处的int值 (由于是整型数据,索引2的起始位置距数组数据区起始处为2 * sizeof(int) = 8字节。在64位系统中,该数据区本身距数组引用起始处偏移16字节,因此总偏移量为24字节,十六进制表示为0x18,故反汇编代码中出现rax+18)。

每次.NET版本发布,都会发现并实现更多机会来避免生成原先存在的边界检查。.NET 10延续了这一趋势。

首个示例源自dotnet/runtime#109900,其灵感来自BitOperations.Log2的实现。该操作在多数架构上具备硬件原生支持,通常BitOperations.Log2会调用可用的硬件原语实现高效运算(如Lscnt.LeadingZeroCount、ArmBase.LeadingZeroCount或X86Base.BitScanReverse),但其备用实现采用查找表方案。该查找表包含32个元素,其操作流程是计算一个uint值,然后向右移位27位以获取最高5位。任何可能的结果都保证是小于32的非负数,但使用该结果对范围进行索引仍会触发边界检查。由于这是关键路径,因此使用了“不安全”代码(即放弃运行时默认提供的保护机制)来规避边界检查。

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD", "value")]

public partial class Tests

{

[Benchmark]

[Arguments(42)]

public int Log2SoftwareFallback2(uint value)

{

ReadOnlySpan<byte> Log2DeBruijn =

[

00, 09, 01, 10, 13, 21, 02, 29,

11, 14, 16, 18, 22, 25, 03, 30,

08, 12, 20, 28, 15, 17, 24, 07,

19, 27, 23, 06, 26, 05, 04, 31

];

value |= value >> 01;

value |= value >> 02;

value |= value >> 04;

value |= value >> 08;

value |= value >> 16;

return Log2DeBruijn[(int)((value * 0x07C4ACDDu) >> 27)];

}

}在 .NET 10 中,边界检查已被移除(注意 .NET 9 程序集存在 call CORINFO_HELP_RNGCHKFAIL 调用,而 .NET 10 程序集中已不存在该调用)。

; .NET 9

; Tests.Log2SoftwareFallback2(UInt32)

push rax

mov eax,esi

shr eax,1

or esi,eax

mov eax,esi

shr eax,2

or esi,eax

mov eax,esi

shr eax,4

or esi,eax

mov eax,esi

shr eax,8

or esi,eax

mov eax,esi

shr eax,10

or eax,esi

imul eax,7C4ACDD

shr eax,1B

cmp eax,20

jae short M00_L00

mov rcx,7913CA812E10

movzx eax,byte ptr [rax+rcx]

add rsp,8

ret

M00_L00:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 74

; .NET 10

; Tests.Log2SoftwareFallback2(UInt32)

mov eax,esi

shr eax,1

or esi,eax

mov eax,esi

shr eax,2

or esi,eax

mov eax,esi

shr eax,4

or esi,eax

mov eax,esi

shr eax,8

or esi,eax

mov eax,esi

shr eax,10

or eax,esi

imul eax,7C4ACDD

shr eax,1B

mov rcx,7CA298325E10

movzx eax,byte ptr [rcx+rax]

ret

; Total bytes of code 58此项改进使dotnet/runtime#118560得以简化实际Log2SoftwareFallback中的代码,避免手动使用不安全构造。

dotnet/runtime#113790 实现了类似场景,即数学运算结果被保证在边界范围内。此处涉及的是 Log2 的运算结果。该变更使JIT编译器能够理解Log2可能产生的最大值,若该最大值在边界范围内,则任何结果都保证在边界内。

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD", "value")]

public partial class Tests

{

[Benchmark]

[Arguments(12345)]

public nint CountDigits(ulong value)

{

ReadOnlySpan<byte> log2ToPow10 =

[

1, 1, 1, 2, 2, 2, 3, 3, 3, 4, 4, 4, 4, 5, 5, 5,

6, 6, 6, 7, 7, 7, 7, 8, 8, 8, 9, 9, 9, 10, 10, 10,

10, 11, 11, 11, 12, 12, 12, 13, 13, 13, 13, 14, 14, 14, 15, 15,

15, 16, 16, 16, 16, 17, 17, 17, 18, 18, 18, 19, 19, 19, 19, 20

];

return log2ToPow10[(int)ulong.Log2(value)];

}

}我们可观察到.NET 9输出中存在边界检查,而.NET 10输出中则缺失:

; .NET 9

; Tests.CountDigits(UInt64)

push rax

or rsi,1

xor eax,eax

lzcnt rax,rsi

xor eax,3F

cmp eax,40

jae short M00_L00

mov rcx,7C2D0A213DF8

movzx eax,byte ptr [rax+rcx]

add rsp,8

ret

M00_L00:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 45

; .NET 10

; Tests.CountDigits(UInt64)

or rsi,1

xor eax,eax

lzcnt rax,rsi

xor eax,3F

mov rcx,71EFA9400DF8

movzx eax,byte ptr [rcx+rax]

ret

; Total bytes of code 29本次选择该基准测试并非偶然。此模式出现在FormattingHelpers.CountDigits内部方法中,该方法被核心基本类型用于其ToString和TryFormat实现,以确定存储数字渲染位所需的空间。与前例相同,该例程被视为核心功能,因此使用了不安全代码来规避边界检查。修复后,代码得以改回使用简单的span访问,即使代码更简洁,运行速度也更快了。

现在考虑以下代码:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD", "ids")]

public partial class Tests

{

public IEnumerable<int[]> Ids { get; } = [[1, 2, 3, 4, 5, 1]];

[Benchmark]

[ArgumentsSource(nameof(Ids))]

public bool StartAndEndAreSame(int[] ids) => ids[0] == ids[^1];

}我有一个方法接受int[]数组,用于检查数组首尾元素是否相同。JIT编译器无法判断该数组是否为空,因此必须进行边界检查;否则访问ids[0]可能导致数组越界。但在.NET 9中我们看到:

; .NET 9

; Tests.StartAndEndAreSame(Int32[])

push rax

mov eax,[rsi+8]

test eax,eax

je short M00_L00

mov ecx,[rsi+10]

lea edx,[rax-1]

cmp edx,eax

jae short M00_L00

mov eax,edx

cmp ecx,[rsi+rax*4+10]

sete al

movzx eax,al

add rsp,8

ret

M00_L00:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 41注意这里有两次跳转到处理边界检查失败的M00_L00标签…这是因为存在两次边界检查:一次用于起始访问,一次用于末尾访问。但这本不必要。ids[^1]等同于ids[ids.Length - 1]。若代码已成功访问ids[0],则说明数组至少包含一个元素;既然数组长度≥1,那么ids[ids.Length - 1]必然在边界内。因此第二个边界检查实属多余。事实上,得益于dotnet/runtime#116105,.NET 10 现已实现此优化(仅需一条分支跳转至 M00_L00 而非两条):

; .NET 10

; Tests.StartAndEndAreSame(Int32[])

push rax

mov eax,[rsi+8]

test eax,eax

je short M00_L00

mov ecx,[rsi+10]

dec eax

cmp ecx,[rsi+rax*4+10]

sete al

movzx eax,al

add rsp,8

ret

M00_L00:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 34真正令我感兴趣的是移除边界检查带来的连锁效应。它不仅消除了边界检查典型的cmp/jae指令对,更改变了.NET 9版本的代码结构:

lea edx,[rax-1]

cmp edx,eax

jae short M00_L00

mov eax,edx在此汇编阶段,rax寄存器存储着数组长度。程序计算ids.Length - 1并将结果存入edx,随后检查ids.Length-1是否在ids.Length范围内(唯一可能超出范围的情况是数组为空导致ids. Length-1 溢出为 uint.MaxValue);若超出范围则跳转至失败处理程序,否则将已计算的 ids.Length - 1 存入 eax。移除边界检查后,可省略中间两条指令,最终代码如下:

lea edx,[rax-1]

mov eax,edx这段代码略显冗余,因为该序列仅需计算递减操作。只要允许标志位被修改,完全可以简化为:

dec eax如.NET 10输出所示,这正是.NET 10当前的实现方式。

dotnet/runtime#115980 处理了另一种情况。假设我有这样一个方法:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD", "start", "text")]

public partial class Tests

{

[Benchmark]

[Arguments("abc", "abc.")]

public bool IsFollowedByPeriod(string start, string text) =>

start.Length < text.Length && text[start.Length] == '.';

}我们验证一个输入的长度是否小于另一个,然后检查另一个输入中紧随其后的内容。我们知道string.Length是不可变的,因此这里的边界检查是多余的,但在.NET 10之前,JIT无法识别这一点。

; .NET 9

; Tests.IsFollowedByPeriod(System.String, System.String)

push rbp

mov rbp,rsp

mov eax,[rsi+8]

mov ecx,[rdx+8]

cmp eax,ecx

jge short M00_L00

cmp eax,ecx

jae short M00_L01

cmp word ptr [rdx+rax*2+0C],2E

sete al

movzx eax,al

pop rbp

ret

M00_L00:

xor eax,eax

pop rbp

ret

M00_L01:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 42

; .NET 10

; Tests.IsFollowedByPeriod(System.String, System.String)

mov eax,[rsi+8]

mov ecx,[rdx+8]

cmp eax,ecx

jge short M00_L00

cmp word ptr [rdx+rax*2+0C],2E

sete al

movzx eax,al

ret

M00_L00:

xor eax,eax

ret

; Total bytes of code 26移除边界检查后,函数大小几乎减半。如果不需要进行边界检查,就可以省略cmp/jae指令对。由于不再需要分支跳转,M00_L01指令不再被调用,因此可移除仅为支持边界检查而存在的call/int指令对。当M00_L01(该方法中唯一的call指令)消失后,前置代码和后置代码均可省略,意味着开头的push和结尾的pop指令也变得多余。

dotnet/runtime#113233 改进了对“断言”(JIT 基于其主张事实进行优化的依据)的处理,使其更少依赖顺序。在 .NET 9 中,这段代码:

static bool Test(ReadOnlySpan<char> span, int pos) =>

pos > 0 &&

pos <= span.Length - 42 &&

span[pos - 1] != '\n';成功移除了对范围访问的边界检查,但以下变体(仅交换了前两个条件的顺序)仍会触发边界检查:

static bool Test(ReadOnlySpan<char> span, int pos) =>

pos <= span.Length - 42 &&

pos > 0 &&

span[pos - 1] != '\n';需注意两个条件均贡献了需合并的断言(事实),方可确定可省略边界检查。而在 .NET 10 中,无论顺序如何,边界检查均被省略。

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private string _s = new string('s', 100);

private int _pos = 10;

[Benchmark]

public bool Test()

{

string s = _s;

int pos = _pos;

return

pos <= s.Length - 42 &&

pos > 0 &&

s[pos - 1] != '\n';

}

}; .NET 9

; Tests.Test()

push rbp

mov rbp,rsp

mov rax,[rdi+8]

mov ecx,[rdi+10]

mov edx,[rax+8]

lea edi,[rdx-2A]

cmp edi,ecx

jl short M00_L00

test ecx,ecx

jle short M00_L00

dec ecx

cmp ecx,edx

jae short M00_L01

cmp word ptr [rax+rcx*2+0C],0A

setne al

movzx eax,al

pop rbp

ret

M00_L00:

xor eax,eax

pop rbp

ret

M00_L01:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 55

; .NET 10

; Tests.Test()

push rbp

mov rbp,rsp

mov rax,[rdi+8]

mov ecx,[rdi+10]

mov edx,[rax+8]

add edx,0FFFFFFD6

cmp edx,ecx

jl short M00_L00

test ecx,ecx

jle short M00_L00

dec ecx

cmp word ptr [rax+rcx*2+0C],0A

setne al

movzx eax,al

pop rbp

ret

M00_L00:

xor eax,eax

pop rbp

ret

; Total bytes of code 45dotnet/runtime#113862 修复了类似场景中断言处理不够精确的问题。请看以下代码:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[MemoryDiagnoser(displayGenColumns: false)]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private int[] _arr = Enumerable.Range(0, 10).ToArray();

[Benchmark]

public int Sum()

{

int[] arr = _arr;

int sum = 0;

int i;

for (i = 0; i < arr.Length - 3; i += 4)

{

sum += arr[i + 0];

sum += arr[i + 1];

sum += arr[i + 2];

sum += arr[i + 3];

}

for (; i < arr.Length; i++)

{

sum += arr[i];

}

return sum;

}

}Sum方法尝试手动展开循环。它跳过对每个元素的分支处理,改为每次迭代处理四个元素。当输入长度无法被四整除时,则通过独立循环处理剩余元素。在.NET 9中,JIT成功省略了主展开循环中的边界检查:

; .NET 9

; Tests.Sum()

push rbp

mov rbp,rsp

mov rax,[rdi+8]

xor ecx,ecx

xor edx,edx

mov edi,[rax+8]

lea esi,[rdi-3]

test esi,esi

jle short M00_L02

M00_L00:

mov r8d,edx

add ecx,[rax+r8*4+10]

lea r8d,[rdx+1]

add ecx,[rax+r8*4+10]

lea r8d,[rdx+2]

add ecx,[rax+r8*4+10]

lea r8d,[rdx+3]

add ecx,[rax+r8*4+10]

add edx,4

cmp esi,edx

jg short M00_L00

jmp short M00_L02

M00_L01:

cmp edx,edi

jae short M00_L03

mov esi,edx

add ecx,[rax+rsi*4+10]

inc edx

M00_L02:

cmp edi,edx

jg short M00_L01

mov eax,ecx

pop rbp

ret

M00_L03:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 92在M00_L00段中可见五个add指令(四个用于求和元素,一个用于索引)。但末尾仍存在CORINFO_HELP_RNGCHKFAIL标记,表明该方法保留了边界检查。该检查源自最终循环,因JIT未能追踪到i值必然非负的特性。而在.NET 10中,该边界检查同样被移除(再次通过CORINFO_HELP_RNGCHKFAIL调用缺失即可验证)。

; .NET 10

; Tests.Sum()

push rbp

mov rbp,rsp

mov rax,[rdi+8]

xor ecx,ecx

xor edx,edx

mov edi,[rax+8]

lea esi,[rdi-3]

test esi,esi

jle short M00_L01

M00_L00:

mov r8d,edx

add ecx,[rax+r8*4+10]

lea r8d,[rdx+1]

add ecx,[rax+r8*4+10]

lea r8d,[rdx+2]

add ecx,[rax+r8*4+10]

lea r8d,[rdx+3]

add ecx,[rax+r8*4+10]

add edx,4

cmp esi,edx

jg short M00_L00

M00_L01:

cmp edi,edx

jle short M00_L03

test edx,edx

jl short M00_L04

M00_L02:

mov esi,edx

add ecx,[rax+rsi*4+10]

inc edx

cmp edi,edx

jg short M00_L02

M00_L03:

mov eax,ecx

pop rbp

ret

M00_L04:

mov esi,edx

add ecx,[rax+rsi*4+10]

inc edx

cmp edi,edx

jg short M00_L04

jmp short M00_L03

; Total bytes of code 102另一项优化来自dotnet/runtime#112824,该方案指导JIT将先前检查中获取的事实转化为具体数值范围,进而利用这些范围折叠后续的关系测试和边界检查。请看以下示例:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

using System.Runtime.CompilerServices;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private int[] _array = new int[10];

[Benchmark]

public void Test() => SetAndSlice(_array);

[MethodImpl(MethodImplOptions.NoInlining)]

private static Span<int> SetAndSlice(Span<int> src)

{

src[5] = 42;

return src.Slice(4);

}

}由于JIT无法确认src长度至少为六,我们必须对src[5]进行边界检查。但当执行到Slice调用时,我们已知该切片长度至少为六——否则写入src[5]将失败。我们可利用此信息移除Slice调用中的长度检查(注意删除了call qword ptr [7F8DDB3A7810]/int 3序列,该序列对应Slice中手动长度检查及抛出辅助方法的调用)。

; .NET 9

; Tests.SetAndSlice(System.Span`1<Int32>)

push rbp

mov rbp,rsp

cmp esi,5

jbe short M01_L01

mov dword ptr [rdi+14],2A

cmp esi,4

jb short M01_L00

add rdi,10

mov rax,rdi

add esi,0FFFFFFFC

mov edx,esi

pop rbp

ret

M01_L00:

call qword ptr [7F8DDB3A7810]

int 3

M01_L01:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 48

; .NET 10

; Tests.SetAndSlice(System.Span`1<Int32>)

push rax

cmp esi,5

jbe short M01_L00

mov dword ptr [rdi+14],2A

lea rax,[rdi+10]

lea edx,[rsi-4]

add rsp,8

ret

M01_L00:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 31再看另一个案例,它对边界检查产生了显著影响(尽管技术上该优化范围更广)。dotnet/runtime#113998通过switch目标生成断言。这意味着switch分支语句的执行体能继承case条件对应的切换依据——例如在switch (x)的case 3分支中,该分支执行体将“知晓”x值为3。这种特性对数组、字符串和span等常用模式尤为有益,开发者常通过长度切换条件,再根据分支结果索引访问数据。请看以下示例:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

using System.Runtime.CompilerServices;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private int[] _array = [1, 2];

[Benchmark]

public int SumArray() => Sum(_array);

[MethodImpl(MethodImplOptions.NoInlining)]

public int Sum(ReadOnlySpan<int> span)

{

switch (span.Length)

{

case 0: return 0;

case 1: return span[0];

case 2: return span[0] + span[1];

case 3: return span[0] + span[1] + span[2];

default: return -1;

}

}

}在 .NET 9 中,这六个 span 解引用操作最终都会触发边界检查:

; .NET 9

; Tests.Sum(System.ReadOnlySpan`1<Int32>)

push rbp

mov rbp,rsp

M01_L00:

cmp edx,2

jne short M01_L02

test edx,edx

je short M01_L04

mov eax,[rsi]

cmp edx,1

jbe short M01_L04

add eax,[rsi+4]

M01_L01:

pop rbp

ret

M01_L02:

cmp edx,3

ja short M01_L03

mov eax,edx

lea rcx,[783DA42091B8]

mov ecx,[rcx+rax*4]

lea rdi,[M01_L00]

add rcx,rdi

jmp rcx

M01_L03:

mov eax,0FFFFFFFF

pop rbp

ret

test edx,edx

je short M01_L04

mov eax,[rsi]

cmp edx,1

jbe short M01_L04

add eax,[rsi+4]

cmp edx,2

jbe short M01_L04

add eax,[rsi+8]

jmp short M01_L01

test edx,edx

je short M01_L04

mov eax,[rsi]

jmp short M01_L01

xor eax,eax

pop rbp

ret

M01_L04:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 103在M01_L04标签下可见明显的边界检查标记(CORINFO_HELP_RNGCHKFAIL),且存在不少于六个跳转指令指向该标签——每个span[...]访问对应一次跳转。但在.NET 10中,我们看到:

; .NET 10

; Tests.Sum(System.ReadOnlySpan`1<Int32>)

push rbp

mov rbp,rsp

M01_L00:

cmp edx,2

jne short M01_L02

mov eax,[rsi]

add eax,[rsi+4]

M01_L01:

pop rbp

ret

M01_L02:

cmp edx,3

ja short M01_L03

mov eax,edx

lea rcx,[72C15C0F8FD8]

mov ecx,[rcx+rax*4]

lea rdx,[M01_L00]

add rcx,rdx

jmp rcx

M01_L03:

mov eax,0FFFFFFFF

pop rbp

ret

xor eax,eax

pop rbp

ret

mov eax,[rsi]

jmp short M01_L01

mov eax,[rsi]

add eax,[rsi+4]

add eax,[rsi+8]

jmp short M01_L01

; Total bytes of code 70CORINFO_HELP_RNGCHKFAIL 标记及其所有跳转指令均已消失。

克隆§

即使无法静态证明每次访问都安全,JIT 仍可通过其他方式移除边界检查。请看以下方法:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private int[] _arr = new int[16];

[Benchmark]

public void Test()

{

int[] arr = _arr;

arr[0] = 2;

arr[1] = 3;

arr[2] = 5;

arr[3] = 8;

arr[4] = 13;

arr[5] = 21;

arr[6] = 34;

arr[7] = 55;

}

}这是在 .NET 9 上生成的汇编代码:

; .NET 9

; Tests.Test()

push rax

mov rax,[rdi+8]

mov ecx,[rax+8]

test ecx,ecx

je short M00_L00

mov dword ptr [rax+10],2

cmp ecx,1

jbe short M00_L00

mov dword ptr [rax+14],3

cmp ecx,2

jbe short M00_L00

mov dword ptr [rax+18],5

cmp ecx,3

jbe short M00_L00

mov dword ptr [rax+1C],8

cmp ecx,4

jbe short M00_L00

mov dword ptr [rax+20],0D

cmp ecx,5

jbe short M00_L00

mov dword ptr [rax+24],15

cmp ecx,6

jbe short M00_L00

mov dword ptr [rax+28],22

cmp ecx,7

jbe short M00_L00

mov dword ptr [rax+2C],37

add rsp,8

ret

M00_L00:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 114即使不精通汇编语言,其模式仍清晰可见:C#代码中对数组进行了八次写入操作,汇编代码中则重复了八次相同模式:cmp ecx,LENGTH用于比较数组长度与预设LENGTH值, jbe short M00_L00 在边界检查失败时跳转至辅助函数CORINFO_HELP_RNGCHKFAIL,以及mov dword ptr [rax+OFFSET],VALUE 将VALUE存储至偏移量OFFSET处的数组位置。在Test方法内部,JIT无法预知_arr的实际长度,因此必须包含边界检查。更关键的是,它必须完整保留所有边界检查(而非合并),因为优化过程中禁止引入行为变更。试想若将所有边界检查合并为单次检查,并生成如下等效代码:

if (arr.Length >= 8)

{

arr[0] = 2;

arr[1] = 3;

arr[2] = 5;

arr[3] = 8;

arr[4] = 13;

arr[5] = 21;

arr[6] = 34;

arr[7] = 55;

}

else

{

throw new IndexOutOfRangeException();

}现在假设数组实际长度为四。原始程序会在抛出异常前将数组填充为[2, 3, 5, 8],但转换后的代码不会(数组不会被写入)。这属于可观察的行为变更。当然,有经验的开发者可以 选择 重写代码来规避部分检查,例如:

arr[7] = 55;

arr[0] = 2;

arr[1] = 3;

arr[2] = 5;

arr[3] = 8;

arr[4] = 13;

arr[5] = 21;

arr[6] = 34;通过将最后一次存储移至开头,开发者为JIT提供了额外信息。JIT现在能判断: 若 首次存储成功,后续存储必然成功,因此JIT将仅生成单次边界检查。但需强调,这是开发者主动改变程序结构的行为,而JIT编译器本身不应进行此类修改。不过JIT编译器确实具备其他优化手段。假设JIT选择将方法重写为:

if (arr.Length >= 8)

{

arr[0] = 2;

arr[1] = 3;

arr[2] = 5;

arr[3] = 8;

arr[4] = 13;

arr[5] = 21;

arr[6] = 34;

arr[7] = 55;

}

else

{

arr[0] = 2;

arr[1] = 3;

arr[2] = 5;

arr[3] = 8;

arr[4] = 13;

arr[5] = 21;

arr[6] = 34;

arr[7] = 55;

}从C#编程思维看,这种写法显得过于复杂——if和else代码块包含完全相同的C#语句。但结合我们对JIT利用已知长度信息省略边界检查的理解,这种写法开始显得合理。以下是.NET 9环境下JIT对此变体的生成代码:

; .NET 9

; Tests.Test()

push rbp

mov rbp,rsp

mov rax,[rdi+8]

mov ecx,[rax+8]

cmp ecx,8

jl short M00_L00

mov rcx,300000002

mov [rax+10],rcx

mov rcx,800000005

mov [rax+18],rcx

mov rcx,150000000D

mov [rax+20],rcx

mov rcx,3700000022

mov [rax+28],rcx

pop rbp

ret

M00_L00:

test ecx,ecx

je short M00_L01

mov dword ptr [rax+10],2

cmp ecx,1

jbe short M00_L01

mov dword ptr [rax+14],3

cmp ecx,2

jbe short M00_L01

mov dword ptr [rax+18],5

cmp ecx,3

jbe short M00_L01

mov dword ptr [rax+1C],8

cmp ecx,4

jbe short M00_L01

mov dword ptr [rax+20],0D

cmp ecx,5

jbe short M00_L01

mov dword ptr [rax+24],15

cmp ecx,6

jbe short M00_L01

mov dword ptr [rax+28],22

cmp ecx,7

jbe short M00_L01

mov dword ptr [rax+2C],37

pop rbp

ret

M00_L01:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 177else代码块编译为M00_L00标签,其中包含之前看到的八个重复代码块。但if代码块(位于M00_L00标签上方)值得关注。该分支仅包含C#代码中初始的array.Length >= 8检查,编译为cmp ecx,8/jl short M00_L00指令对。该代码块其余部分仅包含mov指令(可见数组写入操作实际仅有四次而非八次——JIT将八次四字节写入优化为四次八字节写入)。在我们的重写版本中,我们手动克隆了代码,因此在绝大多数情况下(如果预料到数组写入会失败,我们最初就不会编写这些写入操作),我们只需执行单次长度检查,然后为极少数需要检查的情况准备了“希望永远用不上”的后备方案。当然,您不应(也不需要)进行此类手动克隆。但JIT会为您自动完成此操作。

“克隆”是JIT长期采用的优化策略,当它认为此举能显著优化常见场景时,就会复制此类代码(通常是循环)。如今在 .NET 10 中,得益于 dotnet/runtime#112595,该技术已能应用于此类连续写入操作。回到最初的基准测试,在 .NET 10 环境下我们得到如下结果:

; .NET 10

; Tests.Test()

push rbp

mov rbp,rsp

mov rax,[rdi+8]

mov ecx,[rax+8]

mov edx,ecx

cmp edx,7

jle short M00_L01

mov rdx,300000002

mov [rax+10],rdx

mov rcx,800000005

mov [rax+18],rcx

mov rcx,150000000D

mov [rax+20],rcx

mov rcx,3700000022

mov [rax+28],rcx

M00_L00:

pop rbp

ret

M00_L01:

test edx,edx

je short M00_L02

mov dword ptr [rax+10],2

cmp ecx,1

jbe short M00_L02

mov dword ptr [rax+14],3

cmp ecx,2

jbe short M00_L02

mov dword ptr [rax+18],5

cmp ecx,3

jbe short M00_L02

mov dword ptr [rax+1C],8

cmp ecx,4

jbe short M00_L02

mov dword ptr [rax+20],0D

cmp ecx,5

jbe short M00_L02

mov dword ptr [rax+24],15

cmp ecx,6

jbe short M00_L02

mov dword ptr [rax+28],22

cmp ecx,7

jbe short M00_L02

mov dword ptr [rax+2C],37

jmp short M00_L00

M00_L02:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 179该结构与手动克隆结果几乎完全一致:JIT 编译器两次生成了相同代码,区别仅在于:一种情况省略了边界检查,另一种则包含所有边界检查,并通过单次长度检查决定执行路径。相当巧妙。

如前所述,JIT 编译器多年来一直执行克隆操作,尤其针对数组循环。然而,越来越多的代码开始使用span替代数组,遗憾的是这项宝贵的优化无法应用于span。如今通过dotnet/runtime#113575,这一问题已得到解决!我们可以通过一个基础循环示例来验证:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private int[] _arr = new int[16];

private int _count = 8;

[Benchmark]

public void WithSpan()

{

Span<int> span = _arr;

int count = _count;

for (int i = 0; i < count; i++)

{

span[i] = i;

}

}

[Benchmark]

public void WithArray()

{

int[] arr = _arr;

int count = _count;

for (int i = 0; i < count; i++)

{

arr[i] = i;

}

}

}在WithArray和WithSpan中,我们都使用相同的循环,从0迭代到_count,而_count与_arr的长度之间存在未知关系,因此必须生成某种边界检查。以下是在.NET 9中针对WithSpan生成的代码:

; .NET 9

; Tests.WithSpan()

push rbp

mov rbp,rsp

mov rax,[rdi+8]

test rax,rax

je short M00_L03

lea rcx,[rax+10]

mov eax,[rax+8]

M00_L00:

mov edi,[rdi+10]

xor edx,edx

test edi,edi

jle short M00_L02

nop dword ptr [rax]

M00_L01:

cmp edx,eax

jae short M00_L04

mov [rcx+rdx*4],edx

inc edx

cmp edx,edi

jl short M00_L01

M00_L02:

pop rbp

ret

M00_L03:

xor ecx,ecx

xor eax,eax

jmp short M00_L00

M00_L04:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 59此处存在一些前期汇编操作:将_array加载到span中,加载_count,并检查计数是否为0(若为0则跳过整个循环)。循环核心位于M00_L01指令,该指令反复将edx(存储i)与span长度(存储于eax)进行比较,若发生越界访问则跳转至CORINFO_HELP_RNGCHKFAIL,将edx (即i)写入区间的下一个位置,递增i,若i仍小于count(存储于edi),则跳回M00_L01继续迭代。换言之,每次迭代需执行两项检查:i是否仍在区间范围内,以及i是否小于count。现在来看.NET 9中WithArray的实现:

; .NET 9

; Tests.WithArray()

push rbp

mov rbp,rsp

mov rax,[rdi+8]

mov ecx,[rdi+10]

xor edx,edx

test ecx,ecx

jle short M00_L01

test rax,rax

je short M00_L02

cmp [rax+8],ecx

jl short M00_L02

nop dword ptr [rax+rax]

M00_L00:

mov edi,edx

mov [rax+rdi*4+10],edx

inc edx

cmp edx,ecx

jl short M00_L00

M00_L01:

pop rbp

ret

M00_L02:

cmp edx,[rax+8]

jae short M00_L03

mov edi,edx

mov [rax+rdi*4+10],edx

inc edx

cmp edx,ecx

jl short M00_L02

jmp short M00_L01

M00_L03:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 71此处标签M00_L02与WithSpan中的循环结构高度相似,每次迭代均执行count校验和边界检查。但请注意M00_L00段落:这是相同循环的克隆版本,仍保留每次迭代通过cmp edx,ecx检查i与count的逻辑,却未见额外的边界检查。JIT 编译器克隆了循环,将其中一个特化为无边界检查版本,并在前置段通过单次数组长度检查(cmp [rax+8],ecx/jl short M00_L02)决定执行路径。现在在 .NET 10 中,WithSpan 的实现如下:

; .NET 10

; Tests.WithSpan()

push rbp

mov rbp,rsp

mov rax,[rdi+8]

test rax,rax

je short M00_L04

lea rcx,[rax+10]

mov eax,[rax+8]

M00_L00:

mov edx,[rdi+10]

xor edi,edi

test edx,edx

jle short M00_L02

cmp edx,eax

jg short M00_L03

M00_L01:

mov eax,edi

mov [rcx+rax*4],edi

inc edi

cmp edi,edx

jl short M00_L01

M00_L02:

pop rbp

ret

M00_L03:

cmp edi,eax

jae short M00_L05

mov esi,edi

mov [rcx+rsi*4],edi

inc edi

cmp edi,edx

jl short M00_L03

jmp short M00_L02

M00_L04:

xor ecx,ecx

xor eax,eax

jmp short M00_L00

M00_L05:

call CORINFO_HELP_RNGCHKFAIL

int 3

; Total bytes of code 75与.NET 9中的WithArray类似,.NET 10的WithSpan同样采用循环克隆机制:M00_L03代码块在每次迭代中执行边界检查,而M00_L01代码块则省略每次迭代的边界检查。

在.NET 10中,JIT还获得了更强大的克隆能力。dotnet/runtime#110020、dotnet/runtime#108604 以及 dotnet/runtime#110483 使 JIT 能够克隆 try/finally 代码块,而此前遇到此类结构时会立即终止区域克隆。这看似小众的功能,实则价值非凡——当遍历枚举对象时,foreach循环通常会隐含执行try/finally结构,以便finally块调用枚举器的Dispose方法。

这些优化机制往往相互关联。动态PGO会触发特定形式的代码克隆,这属于前文提及的受保护的虚函数消解(GDV)机制:当仪器数据表明某个虚函数调用通常作用于特定类型的实例时,JIT可将生成的代码克隆为两条路径——一条专用于该类型,另一条处理任意类型。这使得特定类型代码路径能够对调用进行反虚拟化处理,并可能将其内联。若实现内联,则为JIT提供了更多机会来识别对象是否逃逸,从而可能将其堆栈分配。dotnet/runtime#111473, dotnet/runtime#116978, dotnet/runtime#116992、dotnet/runtime#117222、 以及 dotnet/runtime#117295 实现了该功能,通过增强逃逸分析来判断对象是否仅在生成的类型测试失败时才发生逃逸(即目标对象不符合预期的通用类型)。

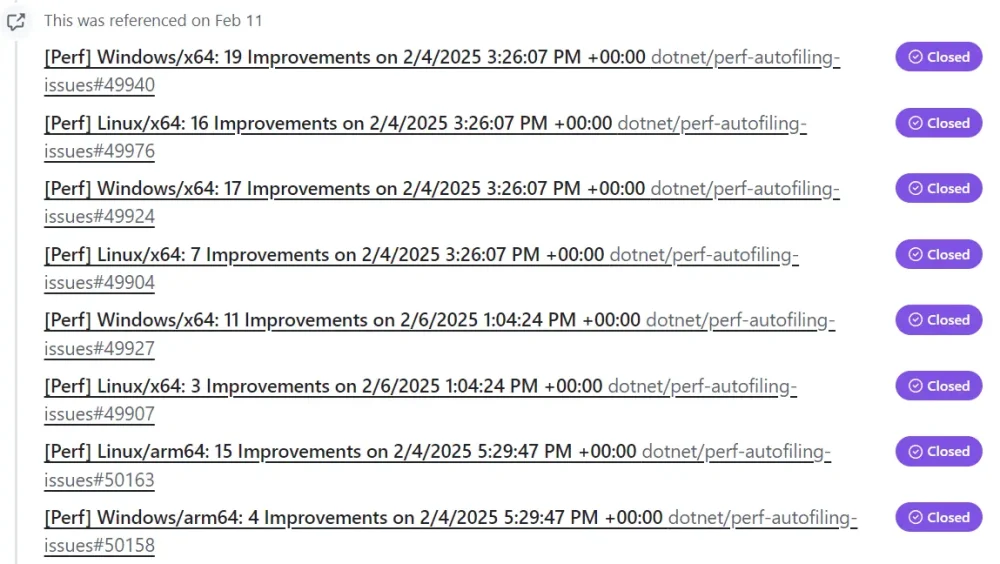

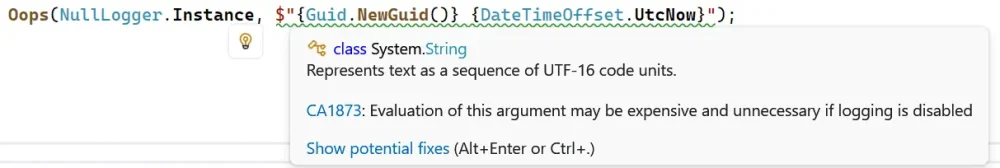

在此需稍作停顿,因我此前描述远不足以彰显此功能的重大意义。dotnet/runtime仓库采用自动化性能分析系统,该系统会标记基准测试的显著提升或退化,并将这些变化追溯至对应的PR。此PR的分析结果如下:

通过简单示例即可理解其价值:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

using System.Runtime.CompilerServices;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[MemoryDiagnoser(displayGenColumns: false)]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private int[] _values = Enumerable.Range(1, 100).ToArray();

[Benchmark]

public int Sum() => Sum(_values);

[MethodImpl(MethodImplOptions.NoInlining)]

private static int Sum(IEnumerable<int> values)

{

int sum = 0;

foreach (int value in values)

{

sum += value;

}

return sum;

}

}借助动态PGO,Sum的仪器化代码会发现values通常是int[]类型,从而能在优化后的Sum实现中为该情况生成专用代码路径。借助条件逃逸分析能力,JIT 编译器能识别出常见路径中 GetEnumerator 生成的 IEnumerator<int> 永不逃逸。因此在所有相关方法被去虚化并内联后,枚举器可直接在栈上分配。

| Method | Runtime | Mean | Ratio | Allocated | Alloc Ratio |

|---|---|---|---|---|---|

| Sum | .NET 9.0 | 109.86 ns | 1.00 | 32 B | 1.00 |

| Sum | .NET 10.0 | 35.45 ns | 0.32 | – | 0.00 |

试想应用程序和服务的多少场景中存在此类集合枚举操作,便能理解这项改进为何如此令人振奋。需注意这些场景甚至未必需要性能优化(PGO)。例如以下情况:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[MemoryDiagnoser(displayGenColumns: false)]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private static readonly IEnumerable<int> s_values = new int[] { 1, 2, 3, 4, 5 };

[Benchmark]

public int Sum()

{

int sum = 0;

foreach (int value in s_values)

{

sum += value;

}

return sum;

}

}在此处,JIT 编译器能够识别到:尽管 s_values 的类型声明为 IEnumerable<int>,但其实际始终是 int[] 数组。在这种情况下,dotnet/runtime#111948 允许在 JIT 中将返回类型重新类型化为 int[],从而使枚举器能够在栈上分配。

| Method | Runtime | Mean | Ratio | Allocated | Alloc Ratio |

|---|---|---|---|---|---|

| Sum | .NET 9.0 | 16.341 ns | 1.00 | 32 B | 1.00 |

| Sum | .NET 10.0 | 2.059 ns | 0.13 | – | 0.00 |

当然,过度克隆可能带来负面影响,尤其会增加代码体积。dotnet/runtime#108771 采用启发式算法判断可克隆循环是否应被克隆:循环规模越大,克隆概率越低。

内联§

“内联”通过用函数实现的副本替换函数调用,始终是至关重要的优化手段。人们常误以为内联的益处仅在于规避调用开销,虽然这确实有意义(尤其在考虑英特尔控制流强制技术等安全机制时,这类机制会略微增加调用成本),但内联的核心价值通常源于连锁效益。以简单示例说明:

int i = Divide(10, 5);

static int Divide(int n, int d) => n / d;若Divide未被内联,则调用时需执行实际的idiv操作,这属于相对昂贵的操作。反之,若Divide被内联,调用点将变为:

int i = 10 / 5;该表达式可在编译时评估,最终简化为:

int i = 2;在逃逸分析和栈分配的讨论中已出现更具说服力的实例,这些特性高度依赖方法内联能力。鉴于内联的重要性日益提升,.NET 10对此进行了重点强化。

.NET 相关内联工作的部分目标在于支持更多类型的内联。历史上,方法中存在多种结构会直接导致该方法无法被纳入内联考虑范围。其中最著名的当属异常处理:包含异常处理语句(如 try/catch 或 try/finally)的方法无法内联。即使像本例中的 M 这样简单的方法:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[MemoryDiagnoser(displayGenColumns: false)]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private readonly object _o = new();

[Benchmark]

public int Test()

{

M(_o);

return 42;

}

private static void M(object o)

{

Monitor.Enter(o);

try

{

}

finally

{

Monitor.Exit(o);

}

}

}在 .NET 9 中仍无法实现内联:

; .NET 9

; Tests.Test()

push rax

mov rdi,[rdi+8]

call qword ptr [78F199864EE8]; Tests.M(System.Object)

mov eax,2A

add rsp,8

ret

; Total bytes of code 21但随着大量PR的提交,特别是dotnet/runtime#112968、dotnet/runtime#113023、 dotnet/runtime#113497 以及 dotnet/runtime#112998 ,包含try/finally的方法不再被阻止内联(try/catch区域仍具挑战性)。在.NET 10上运行相同基准测试时,我们现在得到以下程序集:

; .NET 10

; Tests.Test()

push rbp

push rbx

push rax

lea rbp,[rsp+10]

mov rbx,[rdi+8]

test rbx,rbx

je short M00_L03

mov rdi,rbx

call 00007920A0EE65E0

test eax,eax

je short M00_L02

M00_L00:

mov rdi,rbx

call 00007920A0EE6D50

test eax,eax

jne short M00_L04

M00_L01:

mov eax,2A

add rsp,8

pop rbx

pop rbp

ret

M00_L02:

mov rdi,rbx

call qword ptr [79202393C1F8]

jmp short M00_L00

M00_L03:

xor edi,edi

call qword ptr [79202393C1C8]

int 3

M00_L04:

mov edi,eax

mov rsi,rbx

call qword ptr [79202393C1E0]

jmp short M00_L01

; Total bytes of code 86程序集的具体细节并不重要,但其规模远超以往,因为我们现在主要关注的是 M 的实现。除了支持内联 try/finally 方法外,异常处理方面也进行了其他改进。例如,dotnet/runtime#110273 和 dotnet/runtime#110464 允许移除 try/catch 和 try/fault 代码块,前提是能证明 try 代码块不可能抛出异常。请看以下示例:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD", "i")]

public partial class Tests

{

[Benchmark]

[Arguments(42)]

public int Test(int i)

{

try

{

i++;

}

catch

{

Console.WriteLine("Exception caught");

}

return i;

}

}此处的try代码块无论执行何种操作都不会抛出异常(假设开发者未启用检查算术,否则可能抛出OverflowException),但在.NET 9中生成的程序集如下:

; .NET 9

; Tests.Test(Int32)

push rbp

sub rsp,10

lea rbp,[rsp+10]

mov [rbp-10],rsp

mov [rbp-4],esi

mov eax,[rbp-4]

inc eax

mov [rbp-4],eax

M00_L00:

mov eax,[rbp-4]

add rsp,10

pop rbp

ret

push rbp

sub rsp,10

mov rbp,[rdi]

mov [rsp],rbp

lea rbp,[rbp+10]

mov rdi,784B08950018

call qword ptr [784B0DE44EE8]

lea rax,[M00_L00]

add rsp,10

pop rbp

ret

; Total bytes of code 79而在 .NET 10 中,JIT 编译器能够省略 catch 块并移除所有与 try 相关的仪式化代码,因为它能识别这些仪式化操作是毫无意义的开销。

; .NET 10

; Tests.Test(Int32)

lea eax,[rsi+1]

ret

; Total bytes of code 4即使 try 块调用其他方法且这些方法被内联,使内容暴露于 JIT 分析之下,该特性依然成立。

(顺带一提, JIT 此前已能移除空 finally 的 try/finally 结构,但 dotnet/runtime#108003 在多数优化运行后再次检测空 finally 的情况,以防其他优化揭示出更多空代码块。)

另一个例子是“GVM”。此前,任何调用GVM(泛型虚方法,即带泛型参数的虚方法)的方法都会被禁止内联。

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[MemoryDiagnoser(displayGenColumns: false)]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private Base _base = new();

[Benchmark]

public int Test()

{

M();

return 42;

}

private void M() => _base.M<object>();

}

class Base

{

public virtual void M<T>() { }

}在.NET 9中,上述优化生成的程序集如下:

; .NET 9

; Tests.Test()

push rax

call qword ptr [728ED5664FD8]; Tests.M()

mov eax,2A

add rsp,8

ret

; Total bytes of code 17而在 .NET 10 中,通过 dotnet/runtime#116773,M 现可被内联。

; .NET 10

; Tests.Test()

push rbp

push rbx

push rax

lea rbp,[rsp+10]

mov rbx,[rdi+8]

mov rdi,rbx

mov rsi,offset MT_Base

mov rdx,78034C95D2A0

call System.Runtime.CompilerServices.VirtualDispatchHelpers.VirtualFunctionPointer(System.Object, IntPtr, IntPtr)

mov rdi,rbx

call rax

mov eax,2A

add rsp,8

pop rbx

pop rbp

ret

; Total bytes of code 57内联技术的另一个投资方向在于确定方法何时应被内联的启发式策略。盲目内联所有方法会带来负面影响:内联会复制代码,导致代码量增加,从而产生显著的负面效应。例如,内联增加的代码体积会给缓存带来更大压力。处理器配备指令缓存——这是CPU内存储近期使用指令的小型高速存储器,能实现指令的快速复用(例如循环迭代时或再次调用相同函数时)。假设存在方法M,且有100个调用点同时访问它。若所有调用点共享相同的M指令集(因为这100个调用点实际都在调用M),指令缓存只需加载一次M的指令集。若这100个调用点各自拥有M指令的独立副本,则所有副本都将通过缓存分别加载,彼此之间以及与其他指令争夺驻留空间。指令在缓存中的概率越低,CPU因等待从内存加载指令而停顿的可能性就越高。

因此,JIT需要谨慎选择内联对象。它竭力避免内联无法获益的代码(例如较大方法的指令不受调用上下文实质影响),同时全力内联能显著获益的代码(例如调用函数所需代码与函数内容体积相当的小型函数、指令可能受调用点信息实质影响的函数等)。作为启发式策略的一部分,JIT引入了“增强”机制:当观察到方法的某些行为时,会提升该方法被内联的概率。dotnet/runtime#114806 为返回固定长度小型数组的方法提供增强;若这些数组能在调用方帧内分配,JIT 便可能发现其不存在逃逸风险,从而启用栈分配机制。dotnet/runtime#110596 同样关注装箱操作,因为调用方可能完全避免装箱。

出于相同目的(同时为最小化编译耗时),JIT还会为方法编译中的内联操作设置预算上限——一旦达到预算上限,它可能停止任何内联操作。该预算机制总体运行良好,但在特定情况下可能在极不恰当的时机耗尽预算——例如在顶级调用点大量进行内联后,却在处理对性能至关重要的小型方法时预算已耗尽。为缓解此类场景,dotnet/runtime#114191 和 dotnet/runtime#118641 将 JIT 的默认内联预算提升至原来的两倍以上。

JIT 还高度关注其追踪的局部变量数量(例如 IL 中显式声明的参数/局部变量、JIT 创建的临时局部变量、提升的结构体字段等)。为避免过度创建,当追踪数量达到512时JIT会停止内联。但随着其他改动使内联策略更激进,这个(奇怪地硬编码的)限制值被触发的频率大幅增加,导致许多有价值的内联对象被排除在外。dotnet/runtime#118515 移除了该固定限制,转而将其与 JIT 可追踪局部变量总数的大比例绑定(默认情况下,这几乎使内联器的限制翻倍)。

常量折叠§

常量折叠是编译器在编译时而非运行时执行运算(通常是数学运算)的能力:当存在多个常量及其明确的关联关系时,编译器可将这些常量“折叠”为新常量。例如,当遇到 C# 代码 int M(int i) => i + 2 * 3; 时,C# 编译器会进行常量折叠,最终生成等效于 int M(int i) => i + 6; 的编译结果。JIT 同样支持常量折叠,尤其当其基于 C# 编译器无法获取的信息时更具价值。例如,JIT 能够将 static readonly 字段、IntPtr.Size 或 Vector128<T>.Count 视为常量。JIT 还能跨内联函数进行折叠。例如:

int M1(int i) => i + M2(2 * 3);

int M2(int j) => j * Environment.ProcessorCount;C# 编译器仅能折叠 2 * 3,生成等效代码:

int M1(int i) => i + M2(6);

int M2(int j) => j * Environment.ProcessorCount;但JIT在编译M1时,可将M2内联并视ProcessorCount为常量(本机值为16),最终生成如下M1汇编代码:

// dotnet run -c Release -f net9.0 --filter "*"

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD", "i")]

public partial class Tests

{

[Benchmark]

[Arguments(42)]

public int M1(int i) => i + M2(6);

private int M2(int j) => j * Environment.ProcessorCount;

}; .NET 9

; Tests.M1(Int32)

lea eax,[rsi+60]

ret

; Total bytes of code 4这相当于M1的代码是public int M1(int i) => i + 96;(显示的汇编代码采用十六进制格式,因此60是十六进制0x60,即十进制96)。

或者考虑:

string M() => GetString() ?? throw new Exception();

static string GetString() => "test";JIT 编译器能够内联 GetString 方法,此时它可识别结果非空,从而消除对 null 常量的检查,进而通过死代码消除法移除 throw 语句。常量折叠本身能避免冗余计算,更常为其他优化(如死代码消除和边界检查消除)创造条件。JIT 引擎在发现常量折叠机会方面已相当出色,并在 .NET 10 中进一步优化。请看这个基准测试:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD", "s")]

public partial class Tests

{

[Benchmark]

[Arguments("test")]

public ReadOnlySpan<char> Test(string s)

{

s ??= "";

return s.AsSpan();

}

}以下是为 .NET 9 生成的汇编代码:

; .NET 9

; Tests.Test(System.String)

push rbp

mov rbp,rsp

mov rax,75B5D6200008

test rsi,rsi

cmove rsi,rax

test rsi,rsi

jne short M00_L01

xor eax,eax

xor edx,edx

M00_L00:

pop rbp

ret

M00_L01:

lea rax,[rsi+0C]

mov edx,[rsi+8]

jmp short M00_L00

; Total bytes of code 41值得注意的是两个test rsi,rsi指令,它们是空值检查。程序首先将“”字符串常量的地址加载到rax寄存器,随后通过test rsi,rsi检查rsi寄存器中传递的s参数是否为空。若为空,cmove rsi,rax指令将其设置为“”字面量的地址。接着…它又执行了第二次test rsi,rsi?这个二次检测正是AsSpan开头的空值检查,其代码如下:

public static ReadOnlySpan<char> AsSpan(this string? text)

{

if (text is null) return default;

return new ReadOnlySpan<char>(ref text.GetRawStringData(), text.Length);

}而dotnet/runtime#111985提案将使该次null检查(及其他类似检查)得以折叠,最终生成如下代码:

; .NET 10

; Tests.Test(System.String)

mov rax,7C01C4600008

test rsi,rsi

cmove rsi,rax

lea rax,[rsi+0C]

mov edx,[rsi+8]

ret

; Total bytes of code 25类似效果还来自dotnet/runtime#108420,该提案同样能折叠另一类null检查。

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD", "condition")]

public partial class Tests

{

[Benchmark]

[Arguments(true)]

public bool Test(bool condition)

{

string tmp = condition ? GetString1() : GetString2();

return tmp is not null;

}

private static string GetString1() => "Hello";

private static string GetString2() => "World";

}在此基准测试中, 我们 可观察到GetString1和GetString2均不会返回null,因此is not null检查实属多余。.NET 9的JIT编译器无法识别此特性,但其升级后的.NET 10版本已具备该能力。

; .NET 9

; Tests.Test(Boolean)

mov rax,7407F000A018

mov rcx,7407F000A050

test sil,sil

cmove rax,rcx

test rax,rax

setne al

movzx eax,al

ret

; Total bytes of code 37

; .NET 10

; Tests.Test(Boolean)

mov eax,1

ret

; Total bytes of code 6常量折叠同样适用于SIMD(单指令多数据)指令集,这类指令能同时处理多组数据而非逐个元素处理。dotnet/runtime#117099 与 dotnet/runtime#117572 两个提案均扩展了可参与折叠的SIMD比较运算范围。

代码布局§

当JIT编译器将C#编译器生成的中间语言转换为汇编代码时,会将代码组织为“基本块”——即具有单一入口点和出口点、内部无跳转、仅末端存在分支的指令序列。这些代码块可作为整体进行移动,其在内存中的排列顺序称为“代码布局”或“基本代码块布局”。该排序对性能影响显著,因为现代CPU高度依赖指令缓存和分支预测机制来维持高速运行。若高频执行的“热点”代码块紧密相邻且遵循共同执行路径,CPU可减少缓存未命中和跳转预测失误。反之,若布局不佳——热点代码被拆分至相距甚远的位置,或夹杂着低频执行的“冷代码”——CPU将耗费更多时间在跳转和缓存更新上而非实际运算。以百万次执行的紧凑循环为例: 良好的布局会将循环入口、主体及后向边(跳回主体开头执行下一次迭代的跳转指令)紧邻排列,使CPU能直接从缓存中获取数据。而在不良布局中,该循环可能与无关的冷代码块交织(例如循环内try语句的catch块),迫使CPU从不同位置加载指令,从而破坏执行流畅性。类似地,对于if代码块,高概率路径应直接指向下一代码块以避免跳转,而低概率分支则置于短跳转距离之后——这种布局更符合分支预测器的运作逻辑。代码布局启发式算法控制着上述过程,进而决定了最终生成的代码执行效率。

在确定代码块初始布局时(即布局优化前),dotnet/runtime#108903采用“循环感知逆后序遍历”算法。反后序遍历是一种遍历控制流图节点的算法,确保每个代码块出现在其前驱之后。“循环感知”特性意味着遍历会将循环识别为整体单元,在整个循环外创建代码块,并在布局算法调整时尽力保持循环结构完整。此处的设计意图是让大型布局优化从更合理的起点开始,从而减少后期重组操作,避免循环体被拆分的情况发生。

在极端情况下,布局本质上就是旅行推销员问题。即时编译器必须确定基本代码块的执行顺序,使控制转移遵循短而可预测的路径,从而高效利用指令缓存和分支预测机制。正如推销员试图以最小总行程访问所有城市,编译器也在努力排列代码块,使块与块之间的“距离”(可能以字节数、指令获取成本或其他类似指标衡量)最小化。对于任何具有实际意义的代码块集合,精确计算最优排序的成本都极其高昂——因为可能的排序数量会随代码块数量呈阶乘增长。因此JIT只能依赖近似算法而非追求精确解。当前采用的近似方案(见dotnet/runtime#103450并经dotnet/runtime#109741 和dotnet/runtime#109835中进一步调整)采用的“3-opt”策略,本质上是将所有代码块拆分为三组进行优化排序(仅需验证八种可能的排序方案)。JIT 编译器可选择循环遍历三块代码组,直至不再发现优化空间或达到自设限制。特别在处理后向跳转时,通过dotnet/runtime#110277,该机制将“3-opt”扩展为“4-opt”(四块)。

.NET 10 在将 PGO 数据融入布局方面也更胜一筹。借助动态 PGO,JIT 能够从初始编译中收集仪器数据,并利用这些剖析结果影响优化后的重新编译。这些数据可推断出哪些代码块属于热点或冷点,以及分支走向,所有这些信息都对布局优化至关重要。然而这些剖析数据有时存在缺失,因此JIT采用“剖析合成”算法对空白区域进行合理推测以填补缺口(若您看过《侏罗纪公园》,这相当于用现代青蛙DNA填补恐龙DNA序列缺失的操作)。通过dotnet/runtime#111915,配置文件数据修复现已移至布局阶段前执行,从而使布局获得更完整的数据图景。

让我们通过具体示例说明:我从MemoryExtensions.BinarySearch中提取核心函数:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

using System.Runtime.CompilerServices;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private int[] _values = Enumerable.Range(0, 512).ToArray();

[Benchmark]

public int BinarySearch()

{

int[] values = _values;

return BinarySearch(ref values[0], values.Length, 256);

}

[MethodImpl(MethodImplOptions.NoInlining)]

private static int BinarySearch<T, TComparable>(

ref T spanStart, int length, TComparable comparable)

where TComparable : IComparable<T>, allows ref struct

{

int lo = 0;

int hi = length - 1;

while (lo <= hi)

{

int i = (int)(((uint)hi + (uint)lo) >> 1);

int c = comparable.CompareTo(Unsafe.Add(ref spanStart, i));

if (c == 0)

{

return i;

}

else if (c > 0)

{

lo = i + 1;

}

else

{

hi = i - 1;

}

}

return ~lo;

}

}以下是.NET 9与.NET 10生成的程序集对比(后者为前者差异):

; Tests.BinarySearch[[System.Int32, System.Private.CoreLib],[System.Int32, System.Private.CoreLib]](Int32 ByRef, Int32, Int32)

push rbp

mov rbp,rsp

xor ecx,ecx

dec esi

js short M01_L07

+ jmp short M01_L03

M01_L00:

- lea eax,[rsi+rcx]

- shr eax,1

- movsxd r8,eax

- mov r8d,[rdi+r8*4]

- cmp edx,r8d

- jge short M01_L03

mov r9d,0FFFFFFFF

M01_L01:

test r9d,r9d

je short M01_L06

test r9d,r9d

jg short M01_L05

lea esi,[rax-1]

M01_L02:

cmp ecx,esi

- jle short M01_L00

- jmp short M01_L07

+ jg short M01_L07

M01_L03:

+ lea eax,[rsi+rcx]

+ shr eax,1

+ movsxd r8,eax

+ mov r8d,[rdi+r8*4]

cmp edx,r8d

- jg short M01_L04

- xor r9d,r9d

+ jl short M01_L00

+ cmp edx,r8d

+ jle short M01_L04

+ mov r9d,1

jmp short M01_L01

M01_L04:

- mov r9d,1

+ xor r9d,r9d

jmp short M01_L01

M01_L05:

lea ecx,[rax+1]

jmp short M01_L02

M01_L06:

pop rbp

ret

M01_L07:

mov eax,ecx

not eax

pop rbp

ret

; Total bytes of code 83可见主要变化在于代码块的移动(M01_L00主体下移至M01_L03)。在 .NET 9 中,lo <= hi 的“循环内存检查”(cmp ecx,esi)采用向后条件分支(jle short M01_L00),除最后一次迭代外,每次循环都会跳回顶部(M01_L00)。而在 .NET 10 中,该逻辑改为正向分支:仅在较少出现的异常情况下跳出循环,其余常见情况则直接进入循环主体,随后无条件跳回。

GC 写屏障§

.NET垃圾回收器(GC)采用分代模型,根据对象存活时间对托管堆进行组织。新分配的内存分配在“第0代”(gen0),至少经历过一次回收的对象会被提升至“第1代”(gen1),而存在更久的对象则最终进入“第2代”(gen2)。这种设计基于两个前提:大多数对象具有临时性,且对象存在一段时间后,很可能还会继续存在较长时间。将堆划分为不同代次,使得清扫gen0对象时只需扫描gen0堆中指向该对象的剩余引用。预期所有或绝大多数指向gen0对象的引用都位于gen0代。当然,若指向gen0对象的引用意外进入gen1或gen2代,清扫gen0时未扫描gen1/gen2代将导致严重问题。为避免此类情况,JIT会协同GC追踪从老代到年轻代的引用关系。每当出现可能跨越代际的引用写入时,JIT会调用辅助函数将信息记录在“卡片表”中,当GC运行时便会查询该表以确定是否需要扫描高代区域。该辅助函数即为“GC写屏障”。由于写屏障可能在每次引用写入时触发,其必须具备极高的执行效率。为此运行时提供了多种变体方案,供JIT根据具体场景选择最优方案。当然,最理想的写屏障是根本无需存在的写屏障——正如边界检查机制,JIT同样投入资源尝试证明写屏障的冗余性,并在可行时予以消除。在.NET 10中,优化力度进一步提升。

运行时术语中称为“byref-like类型”的ref struct永远不会驻留在堆上,这意味着其内部的引用字段同样不会驻留堆区。因此,若JIT能证明某次引用写入操作的目标是ref struct的字段,即可省略写入屏障。请看以下示例:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private object _object = new();

[Benchmark]

public MyRefStruct Test() => new MyRefStruct() { Obj1 = _object, Obj2 = _object, Obj3 = _object };

public ref struct MyRefStruct

{

public object Obj1;

public object Obj2;

public object Obj3;

}

}在.NET 9程序集中,我们可看到三个写屏障(CORINFO_HELP_CHECKED_ASSIGN_REF),对应基准测试中MyRefStruct的三个字段:

; .NET 9

; Tests.Test()

push r15

push r14

push rbx

mov rbx,rsi

mov r15,[rdi+8]

mov rsi,r15

mov r14,r15

mov rdi,rbx

call CORINFO_HELP_CHECKED_ASSIGN_REF

lea rdi,[rbx+8]

mov rsi,r14

call CORINFO_HELP_CHECKED_ASSIGN_REF

lea rdi,[rbx+10]

mov rsi,r15

call CORINFO_HELP_CHECKED_ASSIGN_REF

mov rax,rbx

pop rbx

pop r14

pop r15

ret

; Total bytes of code 59通过dotnet/runtime#111576 和 dotnet/runtime#111733 实现后,.NET 10 中所有写屏障均被省略:

; .NET 10

; Tests.Test()

mov rax,[rdi+8]

mov rcx,rax

mov rdx,rax

mov [rsi],rcx

mov [rsi+8],rdx

mov [rsi+10],rax

mov rax,rsi

ret

; Total bytes of code 25然而更具影响力的变更在于dotnet/runtime#112060和dotnet/runtime#112227 更具影响力的改动,它们涉及“返回缓冲区”机制。当.NET方法声明为返回值时,运行时需决定该值如何从被调用方传递回调用方。对于整数、浮点数、指针或对象引用等小型类型,答案很简单:值可通过预留给返回值的一个或多个CPU寄存器传递,使操作基本不耗费资源。但并非所有值都能完美适配寄存器。对于大型值类型(如含多个字段的结构体),则需采用不同策略。此时调用方会在栈帧中分配一块内存区域作为“返回缓冲区”,并将该缓冲区的指针作为隐式参数传递给方法。方法执行时直接将返回值写入该缓冲区,从而向调用方提供数据。关于写屏障的挑战在于:历史上并未强制要求返回缓冲区位于栈上,技术上它完全可能分配在堆上(尽管这种情况极为罕见)。由于被调用方无法知晓缓冲区位置,任何对象引用的写操作都需要通过GC写屏障进行追踪。通过简单基准测试即可验证:

// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0

using BenchmarkDotNet.Attributes;

using BenchmarkDotNet.Running;

BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args);

[DisassemblyDiagnoser]

[HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")]

public partial class Tests

{

private string _firstName = "Jane", _lastName = "Smith", _address = "123 Main St", _city = "Anytown";

[Benchmark]

public Person GetPerson() => new(_firstName, _lastName, _address, _city);

public record struct Person(string FirstName, string LastName, string Address, string City);

}在 .NET 9 中,返回值类型每个字段都会触发 CORINFO_HELP_CHECKED_ASSIGN_REF 写屏障:

; .NET 9

; Tests.GetPerson()

push r15

push r14

push r13

push rbx

mov rbx,rsi

mov rsi,[rdi+8]

mov r15,[rdi+10]

mov r14,[rdi+18]

mov r13,[rdi+20]

mov rdi,rbx

call CORINFO_HELP_CHECKED_ASSIGN_REF

lea rdi,[rbx+8]

mov rsi,r15

call CORINFO_HELP_CHECKED_ASSIGN_REF

lea rdi,[rbx+10]

mov rsi,r14

call CORINFO_HELP_CHECKED_ASSIGN_REF

lea rdi,[rbx+18]

mov rsi,r13

call CORINFO_HELP_CHECKED_ASSIGN_REF

mov rax,rbx

pop rbx

pop r13

pop r14

pop r15

ret

; Total bytes of code 81而在 .NET 10 中,调用约定已更新为要求返回缓冲区驻留在栈上(若调用方需将数据存放于其他位置,则需自行负责后续复制操作)。由于返回缓冲区现已保证位于栈上,JIT 编译器可省略所有作为返回值处理的 GC 写屏障。

; .NET 10

; Tests.GetPerson()

mov rax,[rdi+8]

mov rcx,[rdi+10]

mov rdx,[rdi+18]

mov rdi,[rdi+20]

mov [rsi],rax

mov [rsi+8],rcx

mov [rsi+10],rdx

mov [rsi+18],rdi

mov rax,rsi

ret

; Total bytes of code 35dotnet/runtime#111636 来自 @a74nh 的提案在性能层面同样值得关注,因为正如优化中常见的情况,它实现了某种权衡取舍。在此变更之前,Arm64架构为所有GC模式提供统一的写屏障辅助函数。本次变更使Arm64与x64架构保持一致,通过WriteBarrierManager进行路由,该管理器会根据运行时配置在多个JIT_WriteBarrier变体中进行选择。此举通过增加区域检查并采用区域感知卡标记方案,使每个Arm64写屏障的开销略有增加,但相应地减轻了GC的工作量:卡表中被标记的卡减少,GC可进行更精确的扫描。dotnet/runtime#106191 通过优化热路径比较并消除部分可避免的保存/恢复操作,进一步降低了 Arm64 平台写屏障的开销。

指令集§

.NET 在所有支持架构上持续实现显著优化与改进,同时推出多项架构专属增强。以下列举若干示例:

Arm SVE

Arm SVE 接口于 .NET 9 引入。正如去年博文Arm SVE章节所述,启用 SVE 是历时数年的工程,在 .NET 10 中仍处于实验性支持阶段。但该功能持续获得增强与扩展,例如由@snickolls-arm提交的PRdotnet/runtime#115775新增了BitwiseSelect方法,以及@jacob-crawley提交的PRdotnet/runtime# 117711 来自 @jacob-crawley 添加了 MaxPairwise 和 MinPairwise 方法,以及 dotnet/runtime#117051 来自 @jonathandavies-arm,新增 VectorTableLookup 方法。

Arm64

dotnet/runtime#111893 来自 @jonathandavies-arm,dotnet/runtime#111904 来自 @jonathandavies-arm,dotnet/runtime#111452 来自 @jonathandavies-arm,dotnet/runtime#112235 来自 @jonathandavies-arm,以及 dotnet/runtime#111797 来自 @snickolls-arm,以及 [dotnet/runtime#111797] 例如在实现比较分支时,JIT编译器现在可直接生成cbz(“比较零分支”)指令,而非先生成cmp与0的比较指令再接beq指令。

APX

英特尔于2023年发布的先进性能扩展(APX)是x86/x64指令集的扩展。该扩展将通用寄存器数量从16个增至32个,并新增了条件运算等指令,旨在减少内存访问、提升性能并降低功耗。dotnet/runtime#106557 来自 @Ruihan-Yin, dotnet/runtime#108796 来自 @Ruihan-Yin,以及 dotnet/runtime#113237 来自 @Ruihan-Yin,这些更新本质上教会了JIT如何使用新的汇编语言方言(REX和扩展EVEX编码),而dotnet/runtime#108799 来自 @DeepakRajendrakumaran,更新了 JIT 以支持扩展寄存器集;而 dotnet/runtime#116035 来自 @DeepakRajendrakumaran,启用了用于操作此类寄存器的新推入和弹出指令。APX中最具影响力的指令围绕条件比较(ccmp)展开——该概念在JIT支持其他指令集时已存在。由@anthonycanino提交的dotnet/runtime#111072 dotnet/runtime#112153 来自 @anthonycanino,以及 dotnet/runtime#116445 来自 @khushal1996,这些都教会了JIT如何充分利用APX中的新指令。

AVX512

.NET 8 增加了对 AVX512 的广泛支持,而 .NET 9 则在核心库中显著提升了其处理能力和应用范围。.NET 10 包含大量额外的相关优化:

- dotnet/runtime#109258 来自 @saucecontrol 以及 dotnet/runtime#109267 来自 @saucecontrol,扩展了即时编译器 (JIT) 可使用 EVEX 嵌入式广播的位置数量。该功能允许向量指令从内存中读取单个标量元素,并将其隐式复制到向量的所有通道,而无需单独的广播或洗牌操作。

- dotnet/runtime#108824 移除了广播操作中的冗余符号扩展。

- dotnet/runtime#116117 由 @alexcovington 提交,改进在支持 AVX512 时为

Vector.Max和Vector.Min生成的代码。 - dotnet/runtime#109474 由 @saucecontrol 提交,针对 AVX512 宽化内置函数优化了指令“包含性”(即当指令行为被另一指令完全封装时可被消除) (即指令行为可被另一指令完全封装从而消除)机制,适用于AVX512扩展内置函数(类似的包含性改进已通过@saucecontrol提交的dotnet/runtime#110736实现,以及@saucecontrol提交的dotnet/runtime#111778实现)。(https://github.com/saucecontrol) 及 dotnet/runtime#111778 中的 @saucecontrol 均涉及此类改进)。

- dotnet/runtime#111853 来自 @saucecontrol,改进

Vector128/256/512.Dot以更好地加速 AVX512。 - dotnet/runtime#110195、 dotnet/runtime#110307 以及 dotnet/runtime#117118 共同优化了向量掩码的处理机制。在 AVX512 中,掩码是特殊寄存器,可作为各类指令的组成部分来控制应使用向量元素的子集(掩码中的每个位对应向量中的一个元素)。这使得无需额外分支或洗牌操作即可对向量的一部分进行操作。

- dotnet/runtime#115981 改进了 AVX512 环境下的清零操作(JIT 通常在初始化栈帧时生成清零指令)。在用64字节指令尽可能清零后,原先会降级使用16字节指令,而实际可使用32字节指令。

- dotnet/runtime#110662 通过启用EVEX掩码支持,优化了

ExtractMostSignificantBits函数的代码生成(该函数被核心库中众多搜索算法调用),尤其在处理short、ushort(及char类型——因多数核心库实现会将强制转换的char重新解释为上述类型之一)时。 - dotnet/runtime#113864 由 @saucecontrol 提交,改进了未使用掩码寄存器时

ConditionalSelect的代码生成。

AVX10.2

.NET 9 增加了对 AVX10.1 指令集的支持及内置函数。通过@khushal1996提交的dotnet/runtime#111209,.NET 10新增了对AVX10.2指令集的支持及内置函数。@khushal1996 提交的 dotnet/runtime#112535 使用 AVX10.2 指令优化了浮点数最小值/最大值运算,而 @khushal1996 提交的 dotnet/runtime#111775 则优化了 AVX10.2 指令集的浮点数运算。111775 来自 @khushal1996,则启用了浮点数转换对 AVX10.2 的利用。

GFNI

@saucecontrol提交的dotnet/runtime#109537为GFNI(伽罗瓦域新指令集)添加内置函数,可用于加速伽罗瓦域GF (2^8) 上的运算加速。此类运算常见于密码学、错误校正和数据编码领域。

VPCLMULQDQ

VPCLMULQDQ 是 x86 指令集扩展,为旧版 PCLMULQDQ 指令新增向量支持,该指令可执行 64 位整数的无进位乘法运算。dotnet/runtime#109137 由 @saucecontrol 提交,为 VPCLMULQDQ 添加了新的内置 API。

其他更新§

本次发布中,除已提及的PR外,还有大量PR被合并至JIT模块。以下是部分新增内容:

- 消除部分协变性检查。向引用类型的数组写入数据时可能需要进行“协变性检查”。假设存在基类

Base及其两个派生类型Derived1 : Base和Derived2 : Base。由于.NET中的数组具有协变性,我可以创建Derived1[]数组并成功将其转换为Base[],但底层数据仍为Derived1[]。这意味着,例如尝试将Derived2存储到该数组中,即使编译通过,运行时仍会失败。为实现此目标,JIT 需要在写入数组时插入协变性检查,但与边界检查和写屏障类似,当 JIT 能静态证明这些检查不必要时,即可省略它们。密封类型便是典型示例。当JIT遇到类型为T[]的数组且已知T为密封类型时,T[]必然精确对应T[]而非DerivedT[]——因为根本不存在DerivedT。因此在如下基准测试中:// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0 using BenchmarkDotNet.Attributes; using BenchmarkDotNet.Running; BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args); [DisassemblyDiagnoser] [HideColumns("Job", "Error", "StdDev", "Median", "RatioSD")] public partial class Tests { private List<string> _list = new() { "hello" }; [Benchmark] public void Set() => _list[0] = "world"; }只要JIT能识别

List<string>底层数组为string[](string为密封类型),便无需进行协变性检查。在.NET 9中,我们得到如下结果:; .NET 9 ; Tests.Set() push rbx mov rbx,[rdi+8] cmp dword ptr [rbx+10],0 je short M00_L00 mov rdi,[rbx+8] xor esi,esi mov rdx,78914920A038 call System.Runtime.CompilerServices.CastHelpers.StelemRef(System.Object[], IntPtr, System.Object) inc dword ptr [rbx+14] pop rbx ret M00_L00: call qword ptr [78D1F80558A8] int 3 ; Total bytes of code 44注意

CastHelpers.StelemRef调用…该辅助函数正是执行协变性检查写入操作的实现。但在 .NET 10 中,得益于 dotnet/runtime#107116(该提案教会 JIT 如何解析封闭泛型字段的精确类型),我们得到:; .NET 10 ; Tests.Set() push rbp mov rbp,rsp mov rax,[rdi+8] cmp dword ptr [rax+10],0 je short M00_L00 mov rcx,[rax+8] mov edx,[rcx+8] test rdx,rdx je short M00_L01 mov rdx,75E2B9009A40 mov [rcx+10],rdx inc dword ptr [rax+14] pop rbp ret M00_L00: call qword ptr [762368116760] int 3 M00_L01: call CORINFO_HELP_RNGCHKFAIL int 3 ; Total bytes of code 58无需协变性检查,非常感谢。

- 更强的强度降低。“强度降低”是经典编译器优化技术,通过用加法等低成本操作替代乘法等高成本操作。在.NET 9中,该技术被用于将使用乘法偏移量(如

index * elementSize)的索引循环,转换为仅递增指针式偏移量(如offset += elementSize)的循环,从而削减算术开销并提升性能。在 .NET 10 中,强度缩减技术得到扩展,尤其体现在 dotnet/runtime#110222 提案中。该机制使 JIT 能够检测具有不同步长的多重循环归纳变量,并通过利用它们的最大公约数 (GCD) 进行强度缩减。其核心机制是:根据不同步长值的最大公约数创建单一主递归变量,再通过适当缩放恢复原始递归变量。以下示例说明该机制:// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0 using BenchmarkDotNet.Attributes; using BenchmarkDotNet.Running; BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args); [DisassemblyDiagnoser] [HideColumns("Job", "Error", "StdDev", "Median", "RatioSD", "numbers")] public partial class Tests { [Benchmark] [Arguments("128514801826028643102849196099776734920914944609068831724328541639470403818631040")] public int[] Parse(string numbers) { int[] results = new int[numbers.Length]; for (int i = 0; i < numbers.Length; i++) { results[i] = numbers[i] - '0'; } return results; } }在此基准测试中,我们遍历输入字符串(由2字节字符元素组成),并将结果存储到4字节整型数组中。 .NET 9程序集的核心循环如下:

; .NET 9 M00_L00: mov edx,ecx movzx edi,word ptr [rbx+rdx*2+0C] add edi,0FFFFFFD0 mov [rax+rdx*4+10],edi inc ecx cmp r15d,ecx jg short M00_L00其中

movzx edi,word ptr [rbx+rdx *2+0C]用于读取numbers[i],而mov [rax+rdx* 4+10],edi则用于向results[i]赋值。此处的rdx即为i,因此每次赋值都需执行i * 2来计算索引i处char的字节偏移量,同样需执行i * 4来计算偏移量i处int的字节偏移量。以下是.NET 10程序集:; .NET 10 M00_L00: movzx edx,word ptr [rbx+rcx+0C] add edx,0FFFFFFD0 mov [rax+rcx*2+10],edx add rcx,2 dec r15d jne short M00_L00numbers[i]读取操作中的乘法被移除。取而代之的是每次迭代仅将rcx加2,将其视为第i个char的偏移量;计算int偏移量时也不再乘以4,而是直接乘以2。 - CSE 与 SSA 的集成。与大多数编译器类似,JIT 采用公共子表达式消除(CSE)技术来识别重复计算并避免冗余运算。dotnet/runtime#106637通过将CSE与静态单赋值(SSA)表示更深度融合,使JIT能以更一致的方式执行此操作。这进而触发更多优化机制,例如.NET 9中针对循环归纳变量的强度降低优化未能充分发挥作用,如今该问题已得到解决。

return someCondition ? true : false。相同逻辑常有多种表达方式,但编译器优化过程中往往只识别特定模式,而忽略等效的其他表达。因此编译器需先将所有表达统一规范为更易识别的形式。其中return someCondition的情况尤为典型:由于 JIT 编译器的内部表示机制,等效的return someCondition ? true : false更易于优化。dotnet/runtime#107499 便规范化为后者。以下基准测试可说明此现象:// dotnet run -c Release -f net9.0 --filter "*" using BenchmarkDotNet.Attributes; using BenchmarkDotNet.Running; BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args); [DisassemblyDiagnoser] [HideColumns("Job", "Error", "StdDev", "Median", "RatioSD", "i")] public partial class Tests { [Benchmark] [Arguments(42)] public bool Test1(int i) { if (i > 10 && i < 20) return true; return false; } [Benchmark] [Arguments(42)] public bool Test2(int i) => i > 10 && i < 20; }在 .NET 9 环境下,

Test1的汇编代码如下:; .NET 9 ; Tests.Test1(Int32) sub esi,0B cmp esi,8 setbe al movzx eax,al ret ; Total bytes of code 13JIT 成功识别出可将两个比较操作转换为减法运算和单次比较,如同将

i > 10 && i < 20重写为(uint)(i - 11) <= 8。但对于Test2,.NET 9生成的代码如下:; .NET 9 ; Tests.Test2(Int32) xor eax,eax cmp esi,14 setl cl movzx ecx,cl cmp esi,0A cmovg eax,ecx ret ; Total bytes of code 18由于JIT内部对返回条件的表示方式,该优化未能实现,汇编代码更直接地反映了C#代码的原始逻辑。但在.NET 10中,由于规范化处理,

Test2现在与Test1获得完全相同的优化结果:; .NET 10 ; Tests.Test2(Int32) sub esi,0B cmp esi,8 setbe al movzx eax,al ret ; Total bytes of code 13- 位运算测试。C# 编译器在生成

switch和is表达式时具有高度灵活性。以c is ‘ ’ or ‘\t’ or ‘\r’ or ‘\n’为例,它可能生成等效的级联if/else分支、ILswitch指令、位运算测试,或上述形式的组合。然而C#编译器并不具备JIT编译器拥有的全部信息,例如进程是32位还是64位,或特定硬件上指令的执行成本。通过dotnet/runtime#107831,JIT现在能识别更多可实现为位运算的表达式,并据此生成代码。// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0 using BenchmarkDotNet.Attributes; using BenchmarkDotNet.Running; using System.Runtime.CompilerServices; BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args); [DisassemblyDiagnoser] [HideColumns("Job", "Error", "StdDev", "Median", "RatioSD", "c")] public partial class Tests { [Benchmark] [Arguments('s')] public void Test(char c) { if (c is ' ' or '\t' or '\r' or '\n' or '.') { Handle(c); } [MethodImpl(MethodImplOptions.NoInlining)] static void Handle(char c) { } } }Method Runtime Mean Ratio Code Size Test .NET 9.0 0.4537 ns 1.02 58 B Test .NET 10.0 0.1304 ns 0.29 44 B C# 中常见基于移位值实现的位测试:先创建一个在不同索引位设置的常量掩码,再通过将待检值的位移至对应索引位,判断其是否与掩码位匹配。例如,

Regex类库通过以下方式检测给定的UnicodeCategory是否属于构成“单词”类别的字符集(\\w):// dotnet run -c Release -f net9.0 --filter "*" --runtimes net9.0 net10.0 using BenchmarkDotNet.Attributes; using BenchmarkDotNet.Running; using System.Globalization; BenchmarkSwitcher.FromAssembly(typeof(Tests).Assembly).Run(args); [DisassemblyDiagnoser] [HideColumns("Job", "Error", "StdDev", "Median", "RatioSD", "uc")] public partial class Tests { [Benchmark] [Arguments(UnicodeCategory.DashPunctuation)] public bool Test(UnicodeCategory uc) => (WordCategoriesMask & (1 << (int)uc)) != 0; private const int WordCategoriesMask = 1 << (int)UnicodeCategory.UppercaseLetter | 1 << (int)UnicodeCategory.LowercaseLetter | 1 << (int)UnicodeCategory.TitlecaseLetter | 1 << (int)UnicodeCategory.ModifierLetter | 1 << (int)UnicodeCategory.OtherLetter | 1 << (int)UnicodeCategory.NonSpacingMark | 1 << (int)UnicodeCategory.DecimalDigitNumber | 1 << (int)UnicodeCategory.ConnectorPunctuation; }此前JIT会直接生成与代码逻辑一致的指令:先执行移位操作,再进行位测试。如今通过@varelen提交的dotnet/runtime#111979,它能以位测试形式生成代码。

; .NET 9 ; Tests.Test(System.Globalization.UnicodeCategory) mov eax,1 shlx eax,eax,esi test eax,4013F setne al movzx eax,al ret ; Total bytes of code 22 ; .NET 10 ; Tests.Test(System.Globalization.UnicodeCategory) mov eax,4013F bt eax,esi setb al movzx eax,al ret ; Total bytes of code 15 - 冗余符号扩展。通过dotnet/runtime#111305,JIT现在能移除更多冗余的符号扩展(当将较小类型如

int转换为较大类型如long时,同时保留值的符号)。例如在测试代码public ulong Test(int x) => (uint)x < 10 ? (ulong)x << 60 : 0中,JIT 现可使用mov指令(仅复制位)替代movsxd(带符号扩展的移位),因为它通过首次比较得知移位操作仅在x为非负值时执行。 - BMI2 指令集的改进除法。若 BMI2 指令集可用(通过 [dotnet/runtime#116198] 引入 @Daniel-Svensson 的