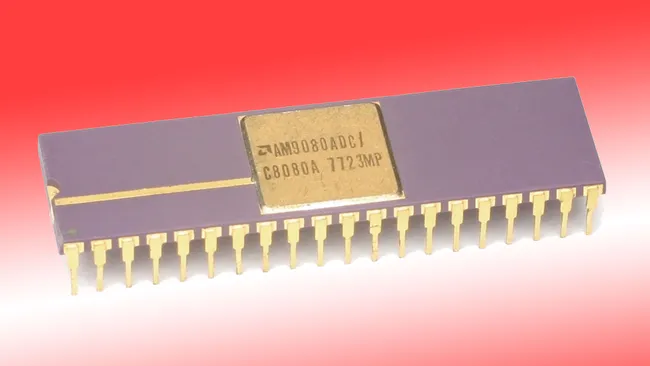

AMD五十年前凭借逆向工程制造的英特尔8080克隆处理器进入CPU市场

Am9080的制造成本仅为50美分,售价却高达700美元

1975年,AMD以50美分的成本制造这些处理器,却以700美元的价格售出,这为公司在个人电脑CPU制造领域奠定了坚实的财务基础。

这款为AMD辉煌未来铺路的芯片,最终催生了我们测试过的最佳CPU,其量产始于50年前。AMD的Am9080诞生过程颇具争议——它实为逆向工程克隆的Intel 8080。然而鉴于军方等机构对8080微处理器的庞大采购需求,第二供应商的战略重要性促使英特尔与AMD最终达成授权协议——正如人们常说的,剩下的就是历史了。

仿制起源

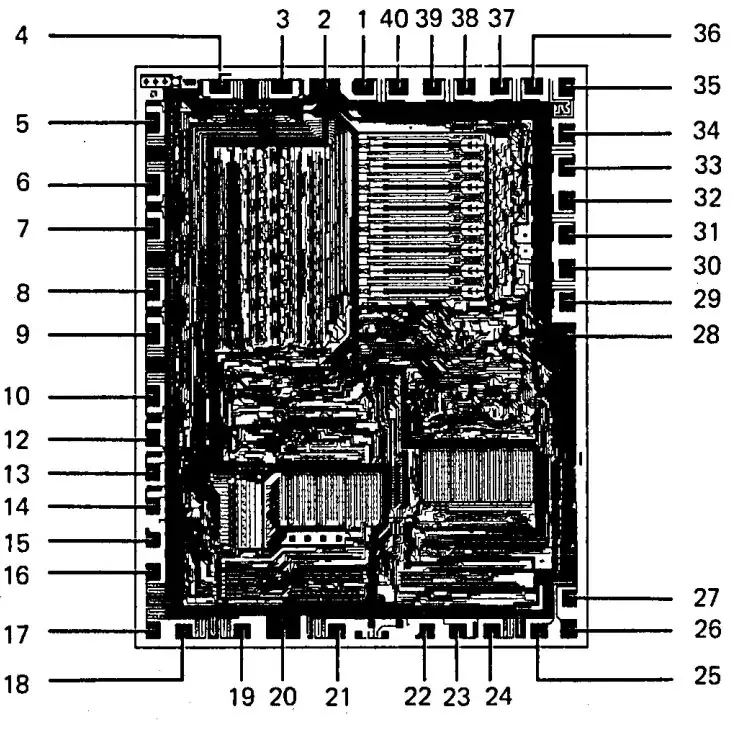

Am9080的诞生过程看似艰辛实则源于模仿。据维基百科记载,1973年夏,阿肖娜·海利、金·海利和杰伊·库马尔在施乐公司最后一天工作时,详细拍摄了英特尔8080的预生产样品照片。

凭借约400张精细照片,三人成功绘制出原理图和逻辑图,随后在硅谷四处兜售以探寻潜在买家。

正如你所料,AMD最终接下了这个项目,认为该处理器可应用于其新研发的N沟道MOS工艺。有资料显示,AMD于1974年售出了首批Am9080——恰逢英特尔该处理器商业化上市之年。但直至1975年,AMD才正式推出并量产Am9080。

成本50美分,售价700美元

结合现有数据——AMD生产Am9080的成本与售价——批量生产这些芯片无疑为公司奠定了坚实基础,成为其商业发展的基石。多方资料显示,单颗Am9080处理器的制造成本仅为50美分(每晶圆100颗),却能以700美元单价售予军方客户。

与英特尔的协议

1976年,AMD凭借其仿制的英特尔8080处理器迎来又一重大商机。为避免旷日持久的法律纠纷,AMD抓住机会与英特尔签署交叉授权协议,获得成为“第二供应商”的授权。

当然,英特尔此举并非出于善意。某些高利润合同(例如军用合同)要求关键组件必须具备第二供应商渠道。双方最终达成协议:AMD签约时支付2.5万美元,每年支付7.5万美元许可费,同时双方就既往侵权行为互免责任。

WikiChip(顶部链接)指出,该协议为芯片巨头间的重大未来协定奠定基础,尤以1982年扩展协议为甚——该协议使AMD得以自主生产x86个人电脑处理器。AMD在扩展协议下推出的首款芯片将是Am286(1982年),这是英特尔80286的授权版本。

Am9080系列最高运行频率达4.0 MHz

AMD为推动芯片业务发展推出了多款Am9080变体。WikiChip列出的28个版本中,时钟频率覆盖2.083至4.0 MHz,工作温度范围从基础款的0-70摄氏度,到符合MIL-STD-883军规的“AM9080ADM” (例如)——该型号可在-70至125摄氏度的极端环境中稳定运行。

AM9080芯片的晶圆尺寸远小于其仿制的英特尔8080处理器,这得益于AMD更先进紧凑的N沟道MOS制造工艺。与当今情况相似,更先进的半导体工艺也实现了更高时钟频率——英特尔8080处理器的所有型号时钟频率从未超过3.125 MHz。

> 50年前,AMD凭借逆向工程的英特尔8080克隆处理器进军CPU市场

启示:当知识产权不再成为阻碍时,惊人的生产力便会诞生。

若我没记错,他们还曾获得过某些克隆产品的生产许可。

记得90年代初am386-40MHz问世时,所有人都惊呼我们突破了音障。当时有家Twinhead(?)公司推出的386-40MHz主板,总线超频过猛导致多数显卡烧毁,唯有单声道赫拉克勒斯卡能幸免。我们当时觉得自己的服务器简直牛逼到爆。

英特尔后来确实授权AMD生产某些克隆产品,但并非出于善意,而是双方达成了交叉授权协议:AMD克隆部分英特尔芯片,英特尔则克隆部分AMD芯片,这些芯片可作为英特尔CPU的外设使用。

后来还有关于英特尔8088及其后续产品的重大授权协议,这是IBM为确保IBM PC关键组件的第二来源而强加给英特尔的。

70年代半导体光罩的法律保护难道不宽松吗?至少在美国是这样?制造工艺或许需要特定专利许可,但芯片本身基本处于无保护状态。

对此我颇感兴趣,并通过链接查阅了原始访谈:https://web.archive.org/web/20131111155525/http://silicongen… 内容颇为引人入胜:

以今日视角看,直接拿英特尔CPU晶圆照片上的设计方案四处兜售给硅谷半导体公司,听起来相当惊人,但当时环境截然不同。

没错,因此英特尔转而走微代码和专利路线。

这并非他们首次推出超越英特尔的产品。我将自己第一台PC的CPU钉在当前搭载锐龙的主机前面板上——记得它时钟频率是20MHz(现在在父母家无法确认),而英特尔产品最高仅12MHz(超频除外)。

我猜那应该是286处理器。当时英特尔产品最高频率12.5MHz,但AMD和Harris最终实现了20甚至25MHz。我至今还保留着搭载12.5MHz处理器的初代电脑。

我认为386的区别在于:据我所知,非英特尔厂商生产的8086和286处理器仍采用授权设计方案。而386(及后续型号)需要重新逆向工程,AMD最终设计了自己的实现方案。这也意味着AMD进入市场稍晚(Am386于1991年问世,而80386早在1985年就已发布),但另一方面,他们得以实现更优异的性能表现。

> 我猜那应该是286处理器。

没错,正是如此。我本该提这个细节的!

> 386(及后续型号)需要通过逆向工程开发……这也意味着AMD进入市场稍晚

法律纠纷同样延缓了其芯片发布。英特尔曾以80386命名侵权¹等理由试图阻挠竞争对手。

> 他们最终实现了更优性能。

很大程度上得益于更快的时钟频率。我有一台运行在40Hz的SX处理器。据我所记得,当时它们在相同频率下功耗更低,能以3.3V电压运行,这使得它们在当时的笔记本电脑中广受欢迎。再加上它们更便宜!英特尔后来推出了支持更好缓存的3.3V型号来与之竞争。

——–

[1] 该策略最终失败,这正是i386(及后续i486、奔腾等无数字型号)品牌诞生的部分原因(但并非唯一因素——转向面向终端消费者而非仅限OEM厂商的营销策略同样起到了关键作用)。

完全赞同。中国市场体现得最为明显。知识产权已从维护竞争的机制,转变为维持市场控制的工具。

鉴于市场控制权是决定企业生死存亡的少数关键因素之一,任何能用于维持市场控制的手段都会被充分利用,这不足为奇。

欧洲国家过去“获取”了大量中国商业机密。公平地说,他们也互相“获取”。

知识产权是登顶后才需要发明的玩意儿。

“踢开梯子”

https://www.amazon.com/Kicking-Away-Ladder-Development-Persp…

美国工业革命的起点,正是塞缪尔·斯莱特将英国纺织厂的详细图纸与机器构造牢记于心,带回本土的时刻。

我怀疑2025年是否还会有公司敢在英特尔的知识产权律师碾压下起步。毕竟他们当年就是靠克隆起家的,这正是中国常被指责的行为。

英特尔客户需要第二供应商(即IBM),因此AMD最初正是为英特尔提供这一角色。后来AMD开发了x86 64位指令集,英特尔直接采纳了该技术,如今双方共享相同指令集架构。

本文讨论的重点并非此处。文章聚焦于AMD Am9080——这款未经授权的英特尔8080克隆产品。

使AMD克隆产品合法化的授权协议是在更晚时期达成的。

你能解释下你试图表达的意思吗?

当垄断者滥用法律扼杀竞争时,客户需求其实无关紧要。这正是垄断行为引发问题的核心症结。

实际情况并非如此。他们的客户是军方。若想获得国防部合同,第二供应商是必需的。

该句中的“必需”应作严格解读:部分客户(主要是政府机构)若无法接触替代供应商(AMD及早期的威盛),原本就不会购买英特尔芯片。英特尔不得不妥协。

当时两家公司都不同于如今。英特尔需要芯片的第二供应商,因为没人信任单一制造商的供应链。

我理解GP的意思是:英特尔为促成首笔交易存在强烈的合作动机。这正是客户需求发挥作用之处。

若公司位于欧盟,当地法规可能鼓励逆向工程。

欧盟或俄罗斯。

可采用硬件加速仿真方案,如苹果在M1处理器中的做法。他们通过硬件实现x86兼容行为,使仿真性能极佳。

另一种方案是Transmeta公司采用的微码实现目标指令集架构,属于“软件”实现方式。

据称他们实现了x86指令集的内存处理指令,这显著提升了仿真速度。具体细节现已记不清,但他们在WWDC的仿真技术视频中详细阐述过。

存在一个通过prctl接口暴露该功能的Linux补丁:https://lore.kernel.org/all/20240410211652.16640-1-zayd_qums…

此外还有CFINV指令(架构指令,属于FEAT_FLAGM),有助于模拟x86-64的CMP指令。

严格来说并非指令集本身。Rosetta是基于软件的二进制翻译器,而x86到ARM翻译中最耗费资源的部分,在于确保所有加载/存储指令严格遵循顺序。为缓解此压力,苹果在硬件层面实现了全存储顺序(TSO)特性,使所有ARM加载和存储指令(透明地)遵循与x86相同的内存顺序规则。

不过有时听到的说法挺有意思:

“苹果造了个非X86芯片!太牛了!最棒的是…它居然像X86那样做TSO!超赞吧?”

也只能偶尔这么说。

我记得上次在Mac上运行amd64系统还是几个月前的事,当时在玩游戏。

苹果并未在硬件层面实现x86指令集架构,他们仅通过几条改变内存行为的指令来加速模拟运行。

除非你找到一家规模堪比当年英特尔的小公司。

我始终强烈主张政府合同必须要求双重供应链——凡涉及关键基础设施、通信技术及医药领域的项目皆应如此。资本主义社会中政府的核心职责,正是尽可能保障市场竞争与本土供应能力。

尽管我的观点以美国为中心,但我认为其他国家也应尽可能优化相同机制。当今诸多问题根源在于过度集中商业/企业权力而非培育竞争。这并非要废除合理监管基准,而是要优化至最符合大众利益的方向。

假设遭遇核打击或灾难导致所有尖端x纳米级工艺中断。我们究竟会失去什么?虽不清楚美国当前最先进制程节点,但假设我们能生产2005年代的CPU,实际会缺失什么?我认为不会影响任何关键领域。所有现有功能都能实现,只是速度变慢。真正的进步在于软件、编程语言和库文件。

当今软件的臃肿程度远超2005年。当时64位CPU虽已面世但尚未普及,“高端”消费级系统仅配备几GB内存,芯片组限制通常将容量封顶在4GB或8GB,拥有双核处理器已属幸运。

若将当今软件运行在内存受限、速度缓慢的2005年代系统上,体验将极其糟糕。

我曾长期使用2008款Thinkpad X200。只要接触现代(即臃肿的)网页,就能感受到明显的迟滞。除网页浏览和游戏外,其他功能运行尚可。

我指的远不止CPU…至于你的问题,我们几乎完全无法体验现代手机。从90纳米到18纳米/1.8纳米工艺,尺寸和能耗都大幅缩减…更别提同期电池和显示技术的飞跃。

现在把这种差距套用到武器系统上——当你(已失去)现代生产能力而敌人却拥有时…这无异于灾难/奴役/死亡的配方。

中国虽受诸多制约,但技术水平早已远超你设想的2005年断点。

更关键的是,这不仅是速度问题,更是实用性问题… 用2005年的技术根本无法构建多数现存网站。当时的性能和内存开销根本无法支撑。倒不是说很多功能不可实现…我对Windows 2000怀有深厚感情,若能配备比普通用户多4-8倍的内存,确实能完成大量工作。

中国如今能制造出媲美2016-18年英特尔水平的CPU。

> 试想这种技术应用于武器系统,却要对抗拥有现代化生产力的敌人——而你自己早已丧失这种能力…这无异于灾难/奴役/死亡的配方。

当弹道导弹突然袭击生产基地,或海上封锁切断国家所有食物供应时,如何维持这种生产?

冗余设计配合防御系统…这与人类历史上所有战争的应对方式并无二致。

若一国CPU技术停留在2005年,另一国却已达2030年水平,冷战或热战中将决定胜负。

若整个社会退回到2005年水平,我们反而能安然无恙。

能否举例说明因IOPS或线程不足导致战争失利的场景?

2004年伊拉克战争中,我们拥有制导导弹、夜视设备、爆炸物和卫星。3纳米晶体管能在实战中为敌人带来什么优势?

“铁穹”防御系统…它能运用人工智能计算来袭导弹轨迹,并有效发射拦截导弹。部分功能或许能实现,但效能将大幅降低。

取决于战况类型,但

看看乌克兰无人机战争…那里发生的事情远不止微型电机等技术。很大程度上依赖于无人机中半导体的高效功耗、摄像头搭载的图像处理器等,我怀疑这些都依赖于更先进的工艺。

正如下方所言,我认为当前及近期的无人机/人工智能战争,以及物联网集成作战系统、传感器与通信网络,在现代硅基芯片支持下能实现更优性能、更低成本和更高速度。

我认为自2005年以来,许多技术进步完全不依赖工艺节点。

我有个冷门理论:软件膨胀呈指数级增长的本质,其实是为了把计算机速度刻意拖慢到普通人能忍受的水平。这正是过去十年里,最臃肿的框架总能取代那些过时但更精简框架的原因。

否则为何如今万物都成了包装层的包装层?倘若这种膨胀——无论出于潜意识还是其他原因——正是设计初衷呢?

更臃肿的框架及其衍生的一系列包,让技术水平较低、经验不足的开发者能更快实现功能开发…尽管许多资深开发者采用的企业级模式本身就伴随着大量臃肿。

Electron虽糟糕透顶,却在实践中实现了前所未有的跨平台应用…它在多个层面都存在臃肿问题。

若非技术进步,我们根本无法如此轻松高效地交付足够完善的软件。

系统的本质终究在于其功能实现。你的观点或许有道理。

阿肖娜的故事颇耐人寻味——当时她约25岁,据维基百科记载,她已参与过军用项目“飞弹系统”,并在施乐公司任职。

> 该处理器由阿肖娜·海利、金·海利和杰伊·库马尔逆向工程开发。海利夫妇在施乐的最后一天拍摄了英特尔8080的预生产样品,并从约400张照片中推导出原理图和逻辑图。

AMD当时已凭借位片式LSI芯片Am2900系列进军CPU市场:https://en.wikipedia.org/wiki/AMD_Am2900

这些芯片以4位片段为单位工作,用户可像乐高积木般组合构建自定义设计(如8位、12位或16位系统),所需元件远少于传统TTL门电路(若采用西摩·克雷的ECL与门方案亦然)。

1980年出版的《位片微处理器设计》一书后来汇集了若干“应用指南”——这些由半导体公司编写的操作手册/速查表,旨在帮助买家/工程师在阅读规格书后快速上手。

英特尔于1974年同时推出NMOS架构的8080处理器与双极性比特切片处理器系列(Intel 3000)。

AMD则在1975年同步发布了NMOS架构的8080克隆产品及双极性比特切片2900系列。

虽无法确定AMD这两款产品何者更早面世,但两者发布间隔至多数月,故不能断言AMD“早已进军CPU市场”。事实上,当这两款产品准备上市时,AMD尚未涉足CPU领域,而英特尔不仅在NMOS CPU市场,更在双极性位片组件市场都领先于AMD。

尽管AMD 2900系列是仿制英特尔8080的产物,但其性能远超英特尔3000系列,因此被广泛应用于众多PDP-11克隆机或竞争机型中。

例如:英特尔3000系列的寄存器+算术逻辑单元模块仅支持2位切片和少量算术运算,而AMD 2900系列的同类模块则支持4位切片并提供更丰富的算术运算功能。

若英特尔决定专注代工业务,我衷心希望AMD与英特尔能携手合作,将x86指令集架构的子集开源或至少开放授权。我不愿看到它重蹈MIPS或POWER指令集的覆辙——一切举措都为时已晚且力度不足。

指令集子集必然与完整指令集不兼容,本质上构成新指令集。现有软件无法在其上运行,因此对任何人都无实际助益。

况且x86架构本身设计欠佳,若要进行不兼容的改造,不如从零开始创建全新、统一、设计完善且现代化的指令集。

> 指令集子集将与完整指令集不兼容,因而构成新指令集。现有软件无法在其上运行。这根本帮不上任何人。

这根本不是问题。数十年来,厂商一直在持续修订指令集的过程中,将硬件中罕用指令移除并通过软件模拟实现。

未实现指令的操作码会触发CPU陷阱,此时缺失指令将在内核仿真层进行模拟。

事实上,这正是早期缺乏浮点运算单元(FPU)的“经济型”80[34]86系统常用的方案——通过模拟实现FPU功能。虽然速度慢如蜗牛,但确实可行。

如今仍有软件在编译时不使用MMX支持。我构想的开放或授权方案是:提供向前兼容的86指令集架构。需要严格向后兼容的客户仍可从AMD和英特尔获取支持。

即:为86架构编译的软件应能在x86平台运行。英特尔和AMD双方均维持向后兼容性价值。若市场需要中间方案,现在有了新选择。

我知道这个想法不够时髦,因为HN或大多数技术人员都喜欢新奇闪亮的东西。但我始终欣赏从“久经考验的旧方案”中挖掘价值的理念。

遗憾的是,过去一年Spotify构建版本都要求AVX扩展支持。我那台搭载Q9300处理器(不支持AVX)的2008年戴尔半升级测试机在更新时遇到了问题。

所幸我能安装旧版二进制文件并锁定更新。

英特尔的软件开发模拟器或许能运行最新版本,但运行速度可能极不稳定。

在其他情况下,AVX扩展并非必需,但应用程序编译时会设置为在缺失时强制失败:https://www.reddit.com/r/pcgaming/comments/pix02j/hotfix_for…

软件或微代码模拟效果相当不错。

因此坚持使用新子集会更快更高效,而启用模拟路径时Nx指令会变慢。

可以说微代码仿真正是当前主流方案。

确实,唯一无法通过微代码仿真解决的是加速解码。

除x86外,多数架构现已采用固定长度指令集,使解码过程快速且可预测。

>真希望AMD和英特尔能携手合作,对x86指令集进行子集化清理

AMD与英特尔庆祝x86生态系统咨询小组成立一周年,共同推动x86计算未来发展

x86特性标准化进程

关键技术里程碑包括:

从指令集架构(ISA)角度看,90年代的x86架构本就可自由使用,对吧?原始专利必然已过期,且指令集本身不受版权保护。维系这种互惠交叉授权双寡头格局的关键,在于持续变异指令集架构,从而混入更多近期专利技术。

据我所知,绝大多数x86_64专利已基本失效,或将在未来6年内到期。不过,推动更开放平台的努力可能更倾向于RISC或ARM替代方案而非x86…虽然我能预见x86兼容的简化方案会在ARM/RISC处理器的仿真平台上标准化。Transmeta的构想实在太超前了。

回想Mac转向ARM架构时,Docker与Node/Python/Lambda跨平台构建在服务器端的痛苦经历,二进制兼容性确实至关重要。

您是在本地桌面直接构建Docker镜像进行部署,而非通过CI/CD服务?

我遇到的最大问题是基于Arm架构的Mac上运行Docker时大量应用崩溃,不过即便如此,我通常也能轻松绕过这些问题。

你需要在本地开发环境中复现构建过程。而且开发项目未必都已成熟,你总要先让它在本地运行起来。CICD流程往往效率低下且难以调试。

当然,但开发环境为何必须与生产环境采用相同架构?不妨将其视为提前进行的二进制翻译。

如今即便是底层系统软件也具备惊人的可移植性。主流GNU/Linux发行版正是通过这种方式为其支持的大多数架构进行开发的。

90%的问题只影响你我这样的开发者和高级用户,而非“普通”机器使用者——他们主要使用移动设备,偶尔用笔记本/台式机运行应用程序。

我怀疑未来十年内,会有某家手机制造商或类似设备厂商悄无声息地从ARM等架构转向RISC-V,我们甚至不会察觉。

我同意,确实会有厂商这么做,但从开发者角度看,这未必是更开放的平台。

实际操作中未必如此。

某些发行版(如Debian或Fedora)只会待专利到期后(若真能到期)才强制采用新特性(如AVX/VEX)。因此新进入者完全可能在专利保护期内实现原始x86-64指令集(或许添加128位原子操作等明显扩展),从而规避因指令集演进导致的专利壁垒。倘若存在仅实现基础指令集的可行AMD/Intel替代方案,这些发行版永远不会转向其他架构。

无论采用何种指令集,打造高性能CPU本就非易事。

他们最近终止了x86s项目。

那个“s”代表“愚蠢”。

但值得庆幸的是,他们意识到x86的核心吸引力在于向后兼容性,试图放弃这一特性只会导致市场份额进一步萎缩。

啥?

>AMD与英特尔庆祝x86生态系统咨询组成立一周年,引领x86计算未来

2025年10月13日

x86特性标准化进程

关键技术里程碑包括:

直接复制粘贴新闻稿并非优质评论。尤其当您似乎既未理解所贴内容,也未把握讨论背景时。您展示的不过是堆砌更多新特性。英特尔撤回的X86S提案实质是移除旧特性,为现代时代打造更精简的子集。

x86S与顾问小组本质相同:都是为了改进x86架构。

目前看来它带来了更多特性,但谁知道明天会带来什么变化?

称x86清理计划已死/取消并不公平,因为这个小组仍在运作。

???

https://www.amd.com/en/blogs/2025/amd-and-intel-celebrate-fi…

正如我链接文章所述,该计划在两个月后被取消

Wtallis你好,能否分析他们放弃该计划的原因?我原本期待x86架构甚至重构部分x86-64指令集,但如今看来这些设想基本落空。

现在提这个太迟了。真有人认为未来10-20年ARM不会彻底取代x86吗?

哪个领域?桌面和高性能服务器?凭什么?

从TSO迁移到弱内存模型的成熟软件库是软护城河。AVX/SIMD的成熟主导地位对阵NEON/SVE也是如此。x86/64是双寡头垄断的稳定目标,而ARM生态则支离破碎。ARM的核心卖点在于性能功耗比,侧重横向扩展而非纵向提升。从这个角度看,市场格局已然转变。若追求持续高吞吐量、高性能及5GHz+运行频率,目前所有优势都将转向x86阵营。

有趣的是,如果AMD在Zen架构中加入ARM前端解码器会怎样。吉姆·凯勒在此分享的某次访谈中提到,打造支持ARM解码的CPU并非难事。这确实值得期待。

> 在哪个领域?台式机和高性能服务器?为什么要这么做?

笔记本领域。苹果在转向ARM架构前就已掌控高利润笔记本市场。当手机、平板、千元以上笔记本及各类电子设备都采用ARM架构时,x86架构不会就此消失——这显然不可能。但随着ARM普及率提升一个数量级,两者的投资回报已不可同日而语。x86架构正缓慢失去竞争力,其芯片在能效比方面普遍落后。这并非源于特定问题或失误,纯粹是经济效益不再成立。

鉴于过去几年围绕该公司的政治/法律博弈,未来十年它很可能自我瓦解,转而拥抱RISC-V或其他全新架构,谁知道呢。

看看SPARC、z/Architecture、PowerPC等架构,即便失去市场主导地位后仍顽强存续至今(而x86阵营根本看不到这种衰退迹象),它们所依赖的软件生态惯性远不及x86的万分之一。

要在如此长的时间内彻底击溃x86,所需条件远比ARM当前的发展轨迹严苛得多。x86已有四十年的发展时间,其技术优势窗口(功耗效率优势)早已关闭。

明确一点:若x86真如SPARC或PowerPC般失宠,我才会认定它被彻底淘汰。

我设想的情形更像是其桌面/笔记本/服务器市场份额跌至10%——即便如此,也远超你列举的那些濒死架构。

忍不住要纠正语义:

市场份额<10%的事物

– macOS

– 除丰田外的所有汽车制造商

被历史视为灭绝的事物:

– 庞贝古城

– 广岛原子弹爆炸半径内的城区

>真有人认为未来10-20年ARM不会彻底取代x86?

月湖平台已证明x86具备同等能效水平

30天后发布的猎豹湖预计将实现显著性能提升

既然能效比相近,何必转向ARM?

在我看来,业界对AArch64架构在本地通用计算场景的应用兴趣已大幅减退。戴尔/惠普企业/联想目前还在销售AArch64服务器吗?或许存在机架式Nvidia DGX变体,但那显然更侧重GPU计算。

二十年仅是x86架构寿命的一半,还不及家用计算机发展史的一半。

因此这个问题本身毫无意义——如此漫长的周期里任何变故都可能发生。二十年前的电脑不过配备512MB内存和单核处理器,桌面上还摆着显像管显示器。

市场为何要从一种专有指令集跳槽到另一种专有指令集?

问苹果公司。

苹果A4芯片比RISC-V早四年问世。

那又怎样?你是说苹果本该转向RISC-V吗?

我欣赏RISC-V(这是我的工作,我深度参与社区),但即便现在它仍不适合笔记本/台式机级应用。RVA23是首个接近成熟的规范,且刚于近期获得批准。更何况笔记本所需的周边技术尚在开发中:ACPI、UEFI等等。了解RISC-V的人都知道,mconfigptr指向什么?目前还指向空!

总之问题在于:为何有人会从一种专有指令集转向另一种?这假设仿佛没人会这么做——尽管有充分证据表明他们绝对会这么做。

“每个成功财富的背后都藏着罪恶。”

——马里奥·普佐《教父》

啊,我记得那些辉煌岁月

用v20芯片替换IBM 8088处理器

瞬间提升20%运行速度

我便宜买了一整盒芯片,跑遍所有电脑把原芯片全换掉

唯一问题是依赖时钟的软件运行速度过快

戈登本该坚持交响乐路线

> Am9080衍生型号最高可达4.0 MHz

初读文章时绝对看错了

>1975年AMD能以50美分成本生产这些处理器,售价却高达700美元

显然是通过欺骗军方客户实现的

>维基百科如是说

这怎么能算一手资料?