内容分发网络(CDN)技术快速理解

CDN,全称为Content DeliveryNetwork,中文意为“内容分发网络“”。通过将网络内容发布到最靠近用户的『边缘节点』,使不同地区的用户在访问相同页面、图片或视频时就可以就近获取。

这样能够减轻服务器的负载,也可以减少整个网络中流量分布不均的问题,既能够降低互联网公司的成本(硬件开销、能耗和管理成本),也能有效改善整个网络的性能。

所谓“边缘节点”指的是CDN服务商经过精心选择的距离用户距离最近的服务器节点,即在各地均有机房集群分布,变得仅是“一跳”距离(traceroute命令后查看经过路由的个数),也就是说用户在访问时不需要经过多个路由器,可以有效提高访问时间。

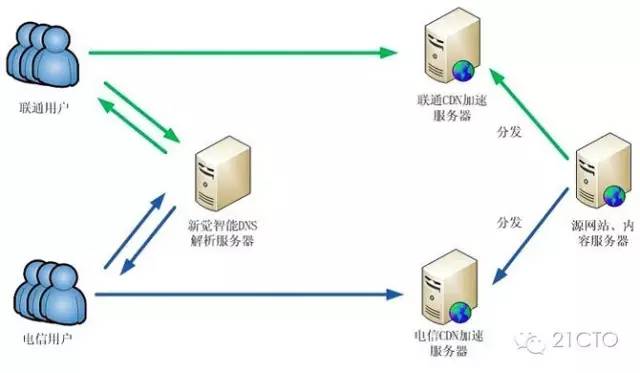

我们来看如下图示:

从上图我们可以看到,在对某个需要CDN的域名解析时,是由智能CDN负载均衡系统选定的某个边缘节点的IP。用户利用这个IP地址访问边缘节点,然后通过该节点通过其内部DNS解析得到源服务器IP并发出请求来获取用户所需的页面或资源。若请求成功,边缘点会将此资源缓存(cache)下来,下次用户再访问时可以直接读取,而不需要每次都去访问源服务器。

CDN架构

可以使用第三方CDN平台,如果有需要也可以自建平台,平台资源用不了再拿出来卖,阿里云等就是这个样子发展的。

那么我们这次就举例说明淘宝的CDN平台是如何架构的。

淘宝网的CDN主要用户来支持用户购物,比如双11光棍节,有海量的图片请求。

它的图片存储于后端的TFS集群中,CDN系统将这些图片缓存到用户最近的边缘节点。

CDN系统采用2级缓存:L1和L2级缓存。用户在访问淘宝网的图片时,通过全局调度系统调度到某个L1级缓存节点,如果L1缓存命中,那么就直接将图片数据返回给用户;否则,即请求L2级缓存,并将返回的图片数据缓存到L1缓存节点。如果L2缓存节点被命中,直接将图片数据返回给L1级缓存节点。

如果都没有命中,最后请求源图片服务器集群。此集群为一个个的Nginx的Web 服务器,它也会在本地做图片缓存,当本地缓存不命中再去请求后端的TFS集群。图片服务器集群和TFS集群会同时部署在同一个数据中心内。如下图:

淘宝网CDN整体架构

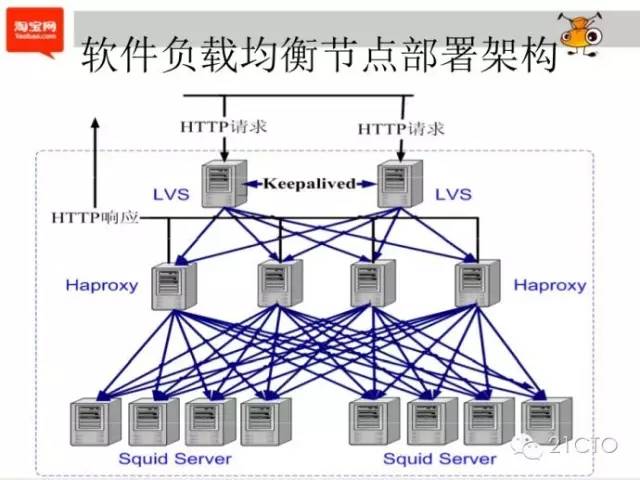

针对于每个CDN节点,其内部通过LVS+HAProxy的方式进行负载均衡。也可以适当使用Keepalived等进行处理。

LVS是四层负载均衡软件,能够支持灵活的负载均衡策略。通过其有机的结合两者,可以将不同的图片请求调度到不同的squid服务器。

LVS通常vip+master+backup三类机器组成,其中vip是控制机器,其接收外界访问。master与backup为工作与热备节点。其可以实现下面Haproxy机器的健康检测与负载均衡,完成IP层的转发后,交给一台健康且相对负载较轻的Haproxy机器。

Haproxy:7层负载均衡技术,将请求转发到真正的Web服务器上。除此之外,还有:

- Haproxy优化-支持长链接;

- Haproxy调度算法优化-一致性哈希,根据访问内容(URL)来得出分配的机器

每台图片服务器本质是一个人的Squid服务器,用来缓存图片的二进制数据。用户请求按照一定的策略发送到某台squid服务器,如果命中即返回,否则squid再去源服务器快取一份图片再缓存到本地,接着再把该图片数据返回给用户。

数据通过一致性哈希分布到不同的squid服务器中,使得增加/删除服务器,只需要移动1/n(squid服务器总数)的对象。

小结

CDN本质是一种分布式缓存系统,无需考虑数据持久化,如果缓存服务器出现问题,在缓存集群中标记为删除即可。

淘宝网CDN采用了分级存储,在Squid服务器上使用了SSD + SAS + SATA混合存储,图片随着热点变化而迁移,最热的图片存储在SSD上,中等热度的存储到SAS,轻热度的存储到SATA。通过此种方式,能够很好的结合几种存储介质的成本与优势。

顺应摩尔定律,硬件技术的不断发展,SSD价格快速下降,大部分CDN缓存节点开始大规模配备SSD设备。

另外,CDN缓存服务属于IO密集型,而非CPU密集型的服务,使用ATOM芯片能够有效整体降低功耗。

需要我们注意的是,缓存系统访问量较大,更新、删除较少,但需要留意缓存与源服务器之间内容的一致性。比如源服务器更换了一张图片,或者删除了一个数据,需要能够相对实时的推送到CDN缓存节点。

你也许感兴趣的:

- 【外评】Amazon S3 不再对多个 HTTP 错误代码收费

- Let’s Encrypt:准备开始签发IP地址证书

- 谷歌浏览器将提供内置翻译和语言检测 API

- OpenAI 将用 Rust 重建 Codex CLI,放弃之前的 TypeScript 版本

- 用 AI 生成的安卓 App:优点、缺点与令人震惊之处

- 为什么所有浏览器的用户代理(User-Agent)都以“Mozilla/”开头?

- 新发现的 Linux udisks 漏洞使攻击者能够在主要 Linux 发行版上获得 root 权限

- 没错,没人关心 Linux 上的使用友好性

- Git Notes:Git 最酷但最不受欢迎的功能

- Kubernetes 2.0 将会是什么样子

你对本文的反应是: