中国开源,又一次让人失望了

出品 | 虎嗅科技组

作者 | 王一鹏

本文为作者分享个人观点,与平台立场无关。

就像过往所有的开源“套壳”事件一样,漩涡中心的主人公们,往往在开源社区和舆论的声讨下成为众矢之的,又在发布回应或道歉信后,快速被遗忘,不论结果与对错。

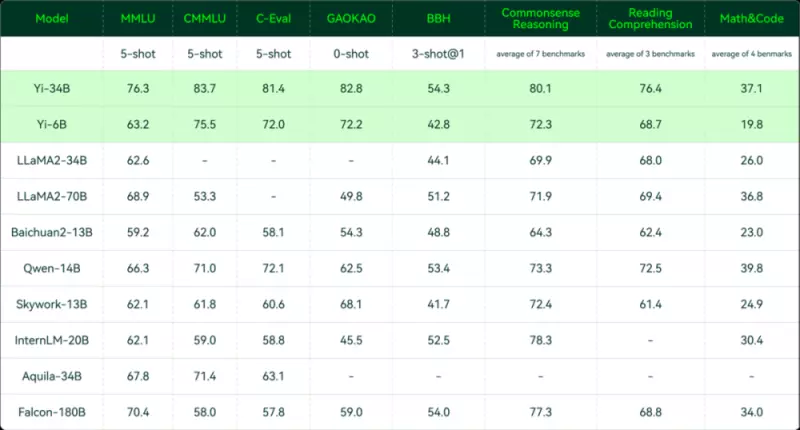

李开复和他的零一万物就是如此。11 月 6 日,零一万物首次公布 Yi-34B 大模型,自豪地宣布 Yi-34B “勇夺全球开源评测‘双料冠军’”。然而仅过了不到一周,在大模型开源社区的主阵地 Hugging Face,就有开发者指出,Yi-34B 完全使用了 Meta 开源的 LLaMA 架构,只修改了两个张量名,且在发布中,全程未提及 LLaMA 的存在。

由于李开复本人的“明星效应”,事件快速发酵,引爆了舆论。11 月 15 日,零一万物发布回应,道歉并承诺把张量名字改回去,同时复盘了零一万物在大模型训练和代码层面所做的工作。

其实李开复是有点委屈的,因为零一万物似乎没做错什么。

一位律师向虎嗅表示,他和来自英美的律师团队,都就此事有过交流。各位律师从各自法域的视角出发进行分析,认为零一万物并未违反 LLaMA 的开源协议。

甚至在国外开源社区,也有不少专家为零一万物鸣不平。事件的源头人物,在 Hugging Face 社区披露此事的 Eric Hartford 在社区不断强调,他只是建议零一万物将修改的张量名改回去,并不带有其他指责,使用 LLaMA 架构没什么问题,模型训练才是一切。

X(Twitter)上也有人回应对零一万物抄袭的指责:荒唐,现在许多大模型都是基于 LLaMA 训练的。况且,事件发生一个月的时间里,Meta 或 LLaMA 社区,自始至终未以官方身份与零一万物,就所谓的“套壳”问题进行交涉,某种程度上也代表了官方的态度。

截止到 12 月 8 日, Yi-34B 在 Hugging Face 上已收获 11 万次下载,显然非常受欢迎。

图片内容来自 Hugging Face

但这些事实,与主流舆论声音无关。在与国内多位媒体人、开发者交流后,我们发现,几乎无人“站队”零一万物。一股萦绕不去的失望、不满,飘荡在零一万物及中国开源的上空。

一场社区争论,

成了捅向零一万物的“刀”

Joséphus Cheung 是在零一万物“套壳”事件中,受到关注较多的一名开发者。在 Hugging Face 的社区,他和前文提到的 Eric Hartford 爆发了一场带着火药味的争论。

Eric Hartford 称零一万物修改张量名就好,其他的没毛病。而 Joséphus Cheung 则认为零一万物此举违反了 LLaMA 的开源协议,是个大问题。

双方的激辩因为 Transformer 核心贡献者、Hugging Face 工程师 Arthur Zucker 及其他开发者的介入而终结,大家回复 Joséphus Cheung 道,LLaMA 的开源协议主要限制了模型权重,而不是模型架构,所以零一万物的 Yi-34B 并未违反开源协议。

有趣的是,这场公开的争论传回国内时就变了味——大量的媒体、UGC 内容单方面引用了 Joséphus Cheung 的言论,称零一万物被开发者警告存在合规风险,而对反对派的声音及最终结论避而不谈。恐怕 Joséphus Cheung 自己也不知道,他的发言已经成为一部分人声讨此事的间接证据。

造成此种问题的原因之一,是大模型技术本身的特殊性。有专家与虎嗅聊到,大模型有三大件:算法、数据和权重。

其中,算法以模型架构为载体呈现,也是零一万物饱受非议的焦点;数据则是大家讨论 AIGC 通常会聊到的数据集,相当于给 AI 提供的学习教材;权重是神经网络的基本概念,代表了两个处理单元之间的连接强度。通俗地来理解,“权重”就像一个员工给另一个员工发消息——有的是普通消息,有的是特别提醒,有的是“Ding”一下。而对于接收消息的员工而言,消息权重越高,影响越大。

这与过往的软件产品截然不同。曾几何时,代码等于一切,对应着大模型概念里的“模型架构”。对于大模型来说,架构只是“三大件”的其中之一。在 Mamba 架构面世未久,Transformer 架构一统江湖的当下,甚至架构的重要性还不如数据和权重。而数据和权重属于工程性问题,对应着模型的训练。有知情人透露,OpenAI 训练 GPT-4 时,可能有 20 个团队同时参与,是相当庞大的工程。

所以,Yi-34B 使用 LLaMA 架构,远远谈不上“套壳”,这是大模型技术本身的特殊性决定的。

有大模型技术专家,对虎嗅就大模型的早期研发问题也做了进一步补充:“LLaMA,GPT 都是基础大模型,基于 Transformer 架构训练,使用了不同的方法,有 encode-decode 结构的,也有像 GPT 类 decode only 的。所以从零开始的话,就是要基于像 transformer 这样的架构重新开发,并自己训练,各大厂商自研大模型都是如此的。还有一类就是基于现有的基础大模型,有 Continue Pretrain,finetune 等方法,进行再训练或者微调,基于 LLaMA 这样的开源架构,有很多团队在上面做工作。”

也就是说,基于 LLaMA 训练大模型,是国内大模型创业的主流形态,至于从零开始自研,有专家表示:“国内没有几家创业公司能做到这事儿,成本很高,算法要求很高,数据集要求很高,工作量很大,也很容易出错。”

另有行业内人士对虎嗅说道:“国内真正从零到一研发大模型的可能也就三家——百度、阿里、智谱。”

当然,上述所有真实情况,并未让零一万物在国内舆论层面得到同情或豁免,甚至也没有使其在技术社区获得更多支持。

一方面,零一万物发布大模型,却对 LLaMA 采取避而不谈的宣传策略——LLaMA 的唯一一次出现,是在 Yi-34B 的竞品性能对比里,且数据指标被超越——难免让人觉得零一万物在道义上对 LLaMA 有所亏欠,在宣传上玩了一个小小的“心机”。

图片内容来自零一万物官方公众号

另一方面,国内的开源历史,实在谈不上阳春白雪,甚至可以说是饱受争议。一桩桩“套壳”公案,屡见不鲜,公众的忍耐度,就像充气过度的气球,处在爆发的边缘。今天对零一万物的所有质疑,其实都是在质疑那个外表光鲜的中国开源。

中国开源,积怨已久

就在今年 8 月 24 日,一款宣称是完全国产、自主研发的 IDE 开发工具上架了,结果被网友扒出是“换皮微软 VSCode”,引发群嘲,两天后出品方致歉并将软件下架。

2021 年,StartRocks 和 Apache Doris 发生纠纷。Apache Doris 本是由百度捐献给 Apache 基金会的数据库项目,StartRocks 则是 Apache Doris 的项目分支,原名叫 DorisDB,鼎石纵横团队围绕 DorisDB 成立商业公司,在品牌方面构成侵权。据思否报道,Apache Doris 的项目导师、孵化器 PMC 都曾联系 StartRocks 进行劝阻,但被无视。一系列纠纷被曝光后,StartRocks 引发众怒,不得已私下与 Apache Doris 达成和解,息事宁人。

2020 年,中科院计算所下属团队号称完全自主设计、开发和实现的编程语言“木兰”,被人发现套壳 Python。相关负责人道歉,说“木兰”编程语言原本要用于中小学教育,是他自己夸大宣传了。

3C 领域更是开源违规的重灾区,小米、一加、文石(电子书厂商),都曾成为社区的集中吐槽对象。中国开源的“违规史”,简直可以写成一本年鉴。

而开源本身带有国际属性,连带使中国优秀的开源人,在国际上遭受不同程度的非议和歧视。

一位国外网友曾在 Reddit 上抱怨道:”这就是我不喜欢中国软件的原因,他们几乎总是不尊重许可证,并尽一切可能逃脱惩罚(This is why i don’t like chinese software.Almost aways they don’t respect licenses and do whatever they can get away with)”。

在很长一段时间里,中国的开源布道者们,都是带着少数优秀项目,与行业惯性和国际歧视“拔河”,时间一久,就会“苦中作乐”——某知名开源基金会布道师对虎嗅表示:“说心里话,现在挺好了,已经有很多进步了。如果是十年前,有人套壳开源软件,甚至不会引发任何讨论和报道,谁关心呢?现在至少大家会讨论这事儿。”

2021 年,Apache Skywalking 创始人吴晟,当选 Apache 基金会第一位华人董事,成为圈子里普天同庆的喜事。

有利可图,无需付出代价,通常是违规行为的诱因。使用免费代码的利益,显而易见。而在开源问题上弄虚作假,确实也不会对国内的企业产生太多实质性影响。

一般套壳的惩罚也不过是道歉并将软件下架,但因为这类软件都是套壳抄袭的,所以也不存在太多研发上的“沉没成本”。

直到 2021 年,国内才出现第一起与开源协议(GPL)有关的侵权案件,被告作为侵权方最终被判罚 50 万元。而与 GPL 协议相关的第一起案件宣判,已经是 2005 年发生在德国的事了。从 2005 年到 2021 年,中国开源在法律层面存在 16 年的实践空白。

在实施力度上,中外也有所差别。在 2005 年的案子里,慕尼黑法院对侵权方 Fortinet 发出了临时禁令,禁止 Fortinet 销售产品,直到符合许可证条款。同时, Fortinet 被迫根据 GPL 协议将他们的 FortiOS (一款服务软件安全领域的操作系统)免费提供给外界。

开源相关侵权案的审理,更多是在参考传统的著作权纠纷案件。与刑事案件不一样,著作权纠纷案件,需要由被侵权方主动发起诉讼。在这起 Fortinet 侵权案中,发起诉讼的是一个非营利性组织 gpl-violations.org,该组织发起于 2004 年,致力于对侵权者施加压力,对侵权行为发起行动。国外,这样的组织不止一个,在国内则难得一见。

那么,资本层面会对开源违规行为做出反应吗?虎嗅也试图就此类问题,与投资人进行沟通,但大家则对此讳莫如深,不愿多谈。目前还未有明确证据显示,国内企业发生开源违规,会导致融资困难。

不过,一名在开源领域创业的 CEO 对虎嗅说道:“如果是在美国,这样的公司(发生侵权、套壳行为的公司)后续就不会拿到融资了。”

真正的痼疾:开源等于免费

实际上,即便不考虑弄虚作假的情况,当下中国的大部分开源项目,也与理想模式相去甚远。大众层面对于开源所有的期待,其实可以用一句话来总结:打破技术垄断,振兴中国技术。但中国开源当下只是个瘦骨嶙峋的孩子,不足以背负这种宏图伟愿。

开源的概念很抽象,公众对其更直观的印象来自一些改变世界的伟大软件,比如:Linux、MySQL、Android,以及如今的 Transformer。其中,Linux 内核遍布全球服务器、IoT 设备,MySQL 撑起全球数据库的半壁江山,Android 撑起手机操作系统半壁江山,Transformer 几乎是所有大模型的架构基础。

将“印象”等化为“期望“,让现实变得有些难以接受。事实上,中国开源的发展目标,在产业侧是妥协过的,创业的 CEO 往往不会太感性,只求先在商业层面获得成功即可。

但“曲线救国”的策略有利有弊,在中国出现一家成功 IPO 的开源企业之前,妥协的恶果已经开始显现。

开源有一条重要的原则叫做“Upstream First”,上游优先原则,意味着企业在免费试用开源代码的同时,也要反馈意见和代码到开源社区,确保社区维护的主干版本可以优先迭代,推动软件不断走向完善。这是开源能够创造价值、互惠互利的“飞轮”。

但一部分国内企业选择竭泽而渔。在他们看来,开源没有这么复杂——开源等于免费。向社区贡献代码?要么招聘几个社区开发者,要么以后再说吧。

这或许也解释了,为什么在 AIGC 快速发展的 2023 年,中国企业在大模型上的爆发,仅限于数量——抄来的终究是别人的,不参与开源贡献,通常也不会具备真正的技术优势。

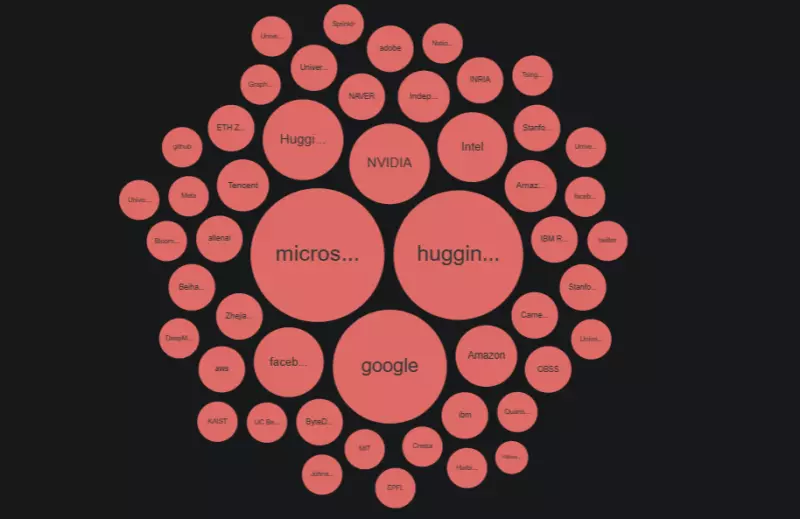

大模型在架构上的源头是 Transformer,据 OSS Insight 数据统计,在 Transformer 社区中,提 Issue(答疑交流、反馈缺陷)的 Top 10 榜单,只有两家中国单位,一个是北京大学,一个是清华大学,没有一家中国企业。前五分别是:微软、Hugging Face、谷歌、卡内基梅隆大学、英特尔。

在 Pull Request(贡献代码) Top 10 榜单里,只有腾讯一家公司入榜,排在第十,前五分别为:微软、Hugging Face、谷歌、英伟达、Facebook(Meta)。

Transformer 各企业 Pull Request 占比,内容来自 OSS Insight 网站

细看两个榜单的前五名公司,微软和谷歌皆是当今 AIGC 领军人物,联手奠定了当今的 AI 格局。Meta 发布了开源 LLaMA 大模型,成为最被中国企业青睐的“借鉴对象”。Hugging Face 仅用一年时间就实现了估值翻倍,如今估值超过 40 亿美金,NBA 球星杜兰特也参与了其天使轮融资。

卡内基梅隆大学,前段时间刚与斯坦福大学联手发布了 Mamba 架构,号称要颠覆 Transformer。它实现了公众对于开源的期待——学习、参与,最终完成超越。

再看看 LLaMA,Issue(答疑交流、反馈缺陷) Top 10 榜单,没有一家中国公司入选,只有哈尔滨工业大学排在第五;Pull Request(贡献代码) Top 10 榜单,有三家中国公司:星鲸科技、腾讯、水木分子生物科技,分别排在第四、第八、第十位。

近五年,以 BAT、字节为代表的头部企业,也注意到这个问题,纷纷成立开源办公室,希望能塑造企业内的开源文化。但其中一部分项目,又被行业戏称为“KPI 式开源”——指员工为了完成 KPI 而去更新开源项目,该项目的寿命因 KPI 完成或岗位变动而终结。甚至有开源社区专家表示,根本不相信所谓的“大厂开源”,认为其天然在社区贡献者多样性这个问题上存在劣势。

目前公认比较健康的开源项目,大部分集中在云原生、大数据领域,分别捐赠给了 Linux 基金会和 Apache 基金会。至于剩余的百余家国产大模型企业,99% 不在这些榜单里。近期关于 AIGC 的一系列重磅进展,也忠实地反映了这个结果。

这个结局,企业能接受,投资人能接受,某种意义上,部分开源人也能接受。剩余不能接受的人,满怀愤怒。这让所有的明星开源创业团队,都像坐在“火药桶”上创业,一个火星,就能让人灰飞烟灭。

本文文字及图片出自 InfoQ

你也许感兴趣的:

- Redis 再次开源

- 【外评】一位中国程序员的开源之旅

- 【程序员搞笑图片】你们干扰不了我写开源代码

- 【外评】哪些开源项目被广泛使用,但仅由少数人维护?

- 【外评】瑞士现在要求所有政府软件都必须开源

- 【外评】开源既不是社区,也不是民主

- Winamp 宣布将开放源代码

- 【外评】什么是开源贡献,什么不是开源贡献?

- 【译文】开放源代码与微软:新的反叛开始了

- 开源 Redis 的生命将就此终结?Redis 之父回应分叉浪潮:未来谁能领先,各凭本事!

你对本文的反应是: