【外评】LLM 大语言模型无法回答的问题及其重要性

LLM 都无法回答的问题

“《吉利根之岛》哪一集是关于读心术的?”

除非使用网络搜索,否则任何 LLM 都无法正确回答这个问题。但是,如果 LLM 是根据整个互联网的数据,当然也很有可能是 IMDB 中的所有数据训练出来的,又怎么会不知道答案呢?正确答案是 “Seer Gilligan“,最受欢迎的剧集之一。

以下是多个顶级模型的回答:

Opus

很抱歉,”Seer Gilligan” 中没有一集是专门讲述读心术的。

GPT 4

“Seer Gilligan”中涉及读心术的一集名为 “环绕吉利根”。它是第三季的第六集。

Gemini 双子座 1.5

“Seer Gilligan”中有读心术的一集是第 2 季第 12 集–“读心术”。

Llama 3

经过彻底搜索和查阅剧集指南,我发现”Seer Gilligan”中没有一集专门讲述读心术。

Llama 3 – 要求列出剧集并说出剧集名称

“The Postman Cometh” (March 13, 1965)

“Seer Gilligan” (Wait, no! I apologize, but there is no episode titled “Seer Gilligan”)

“Love Me, Love My Chicken” (March 20, 1965)请注意,没有名为 “Seer Gilligan “的情节。如果您有任何其他问题或需要有关特定情节的帮助,请随时提出!

所有四个模型都没有给出正确答案。其中两个模型产生了幻觉,其余两个则否认存在这样的情节。有趣的是,通过对 Llama 3 的进一步探究,我们发现它知道有这一集,但仍然否认它的存在。它似乎知道有 98 集,但它列出的大部分标题都是编造的。

就 Llama 3 而言,我们可以使用 Infini-gram探查部分训练数据集,并验证语料库中确实存在该剧集以及描述该剧集的文本。

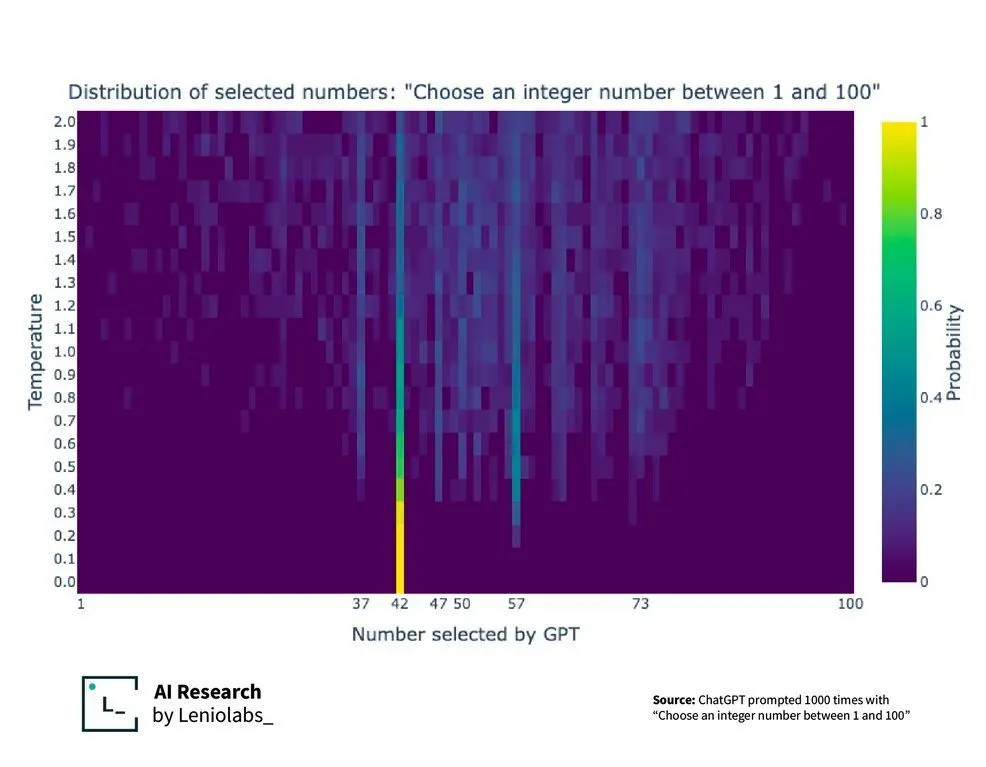

当要求 LLM 提供 1-100 之间的数字时,我们还发现了另一个有趣的数据和训练现象。它们都趋同于 42!

Information is Beautiful 一文指出,当要求人工智能在 1 到 100 之间选择一个数字时,会形成一个非常有趣的分布。选择 “42 “这个数字的权重很高。这很可能是Hitchhiker’s Guide to the Galaxy 的效应。通过训练,42 这个数字在某种程度上被过度代表或加权,导致 LLM 更倾向于选择 42。

这意味着什么?影响…

其含义是,LLM 并不像大多数人想象或希望的那样对数据进行推理。

它不会对自己的信息进行自我反思;它不知道自己知道什么,不知道自己不知道什么。幻觉与真相之间的界限只是一种概率,由训练数据的普遍性和训练后的微调过程等因素决定。可靠性永远只是建立在这一架构之上的概率而已。

因此,它并不适合作为发现罕见的隐藏真相或有价值的被忽视信息的机器。它永远只会向流行的叙述或数据靠拢。充其量,它可以为现有的众所周知的概念提供新的排列组合,但却无法发明新的概念或揭示鲜为人知的概念。

“你无法将现实缓存在某个压缩查找表中。如果特定结果从未出现在训练数据中,模型就会进行随机猜测,而这是相当有限的。

– Chomba Bupe

此外,它永远不可能是一个绝对可靠的系统。需要确定性、可证明正确行为的关键任务系统并不适用于 LLM 自动化或控制。问题在于,LLM 在出错时也能让人信服,这可能会导致不明智的采用。有哪家企业愿意用一个会产生幻觉的计算器来平衡账目呢?

影响:

- 结果是一种概率,更多的是由数据的普遍性而非逻辑或理性来定义。

- 在特定问题上,LLM 的可靠程度是无法辨别的。

- 这对于发现未被发现的真理或被忽视的绝妙想法毫无用处。

- 无法将新概念或新发现理论化。

令人啼笑皆非的是,LLM 在吸引数十亿投资的主要用例上失败了,但在我们不希望出现的用例上却相当精通,如破坏隐私和自由、后真相社会、社会操纵、切断人与人之间的联系、噪音喷泉、意义贬值以及其他大量社会问题。

与现在大多数互联网不同,”心灵监狱 “的所有内容背后都有一个人的头脑。我通常要花费数小时至数天的时间来撰写文章,包括为每篇文章绘制插图。我希望,如果您觉得这些文章很有价值,而且您仍然欣赏来自某人头脑中有机硬件的创作,那么您可以考虑订阅。谢谢!

本文文字及图片出自 The question that no LLM can answer and why it is important

你也许感兴趣的:

- 【程序员搞笑图片】当AI大模型看到没有训练过的数据

- 当你告诉大语言模型(LLM) 旁边有一部智能手机时,会发生什么?

- 【外评】训练与聊天不同:ChatGPT 和其他 LLM 不会记住你说的每一句话

- 大模型永远也不做了的事情是什么?

- 【外评】谷歌搜索结果被人工智能编写的错误代码污染,令程序员沮丧不已

- 【外评】LLM 无法处理概率问题

- LLM 大语言模型人工智能应用十大安全威胁(OWASP)

- 【外评】LLM大型语言模型与哈利波特问题

- 比 Rust 更难的都不足为惧

- LLM对程序员的冲击和影响

你对本文的反应是: